前言

不考虑运行时间和效率问题的话,小规模爬虫程序,selenium是最好最合适的python爬虫库。这篇讲一下如何实现用selenium进行爬虫。

环境配置- 系统:win10 (64位)

- 浏览器: chrome (推荐大家都用这个)

- 编译器:pycharm

- python版本:python3, 我用的是3.7

参考方法 Pycharm下载第三方包 输入命令: pip install selenium即可。

这一步不可或缺, 否则程序将会报错。 首先确认自己的chrome版本, 点击chrome界面右上角, 设置或访问本链接  记住这里小数点前的第一个数, 这里我是81。

记住这里小数点前的第一个数, 这里我是81。

然后去chrome driver 官网, 下载相应匹配的版本, 如:

这里选一个81开头的就行了,

这里选一个81开头的就行了,  再选择windows版本下载即可。

再选择windows版本下载即可。

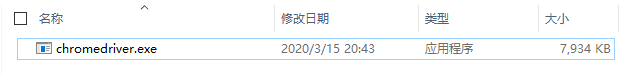

解压后可以得到如下的exe文件:

首先找到自己安装的chrome的源地址,即chrome.exe的文件夹:  这个可以用everthing都快速找出, 也可以右键chrome快捷方式,点击属性查看位置。 找到该文件夹后, 将刚刚解压的chromedriver.exe文件复制粘贴进入即可。

这个可以用everthing都快速找出, 也可以右键chrome快捷方式,点击属性查看位置。 找到该文件夹后, 将刚刚解压的chromedriver.exe文件复制粘贴进入即可。

from selenium import webdriver

Chromedriver_path = 'C:/Program Files (x86)/Google/Chrome/Application/chromedriver.exe'

driver = webdriver.Chrome(Chromedriver_path)

driver.get('www.baidu.com)

运行上述代码,就能用selenium打开百度啦。 其中第二句的地址替换为你自己刚复制的chromedriver的地址即可, 然后最后一句的url可以改为你想爬取的网页地址。

按这样三步,就成功配置好了selenium! 最后推荐下selenium的官方教程,非常好用,极易上手:

selenium 教程