欢迎点击「算法与编程之美」↑关注我们!

本文首发于微信公众号:"算法与编程之美",欢迎关注,及时了解更多此系列文章。

在大数据盛行的时代,数据作为资源已经是既定事实。但是面对海量的数据,如何有效找出所需的数据资源是目前亟待解决的问题。而网络爬虫技术就可以有效解决这个问题。Python作为开发最高效的工具也网络爬虫的首选,但python自带的第三方库不足以解决爬虫所需。所以今天我们就来介绍一下,python爬虫常用的第三方库~

Beautiful Soup

Beautiful Soup直译为美丽的汤,这碗汤也确实是一碗功能强大的美味的汤。这是python里自带的一个库,主要被用于网页数据的抓取。他通过解析编码文档,自动转换为“utf-8”,当然如果有指定的编码,也可以手动加入encoding设为其他编码。

在cmd中输入安装命令:pip install beautifulsoup4即可安装。

Requests

Request直译为需求,是python中一个简单的HTTP库。他常与get的方式连用,接收各种请求。

而requests库的功能也很强大,他可以实现代码的跳转,相应命令,传输文件等功能。

在cmd中输入安装命令:pip install requests即可安装。

Lxml

数据解析是网络爬虫中重要的第二步,虽然Python的标准库中自带有xml解析模块

但第三方库lxml库更是python解析的有利工具,支持多种解析方式,而且解析效率也是极高的。

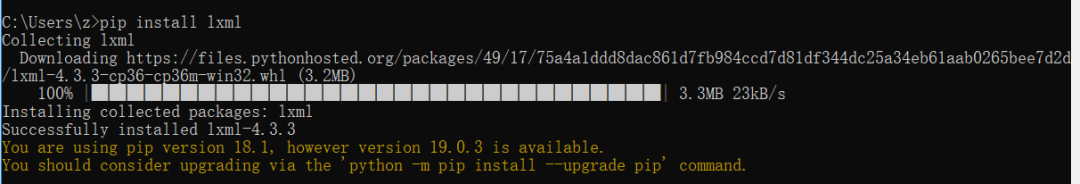

在cmd中输入安装命令:pip install lxml即可安装。

而在安装此库时,常常会有升级提示:

所以我们可以按照提示进行升级,

最后,给大家安利一个python的开发环境:pyCharm

建议大家下载社区版本就够用了哟~

而且还是免费的:)

更多精彩文章:

where2go 团队

微信号:算法与编程之美

长按识别二维码关注我们!

温馨提示:点击页面右下角“写留言”发表评论,期待您的参与!期待您的转发!