title: Redisauthor: Xonitags:

- Rediscategories:

- java学习

- Redisabbrlink: bae4ff13

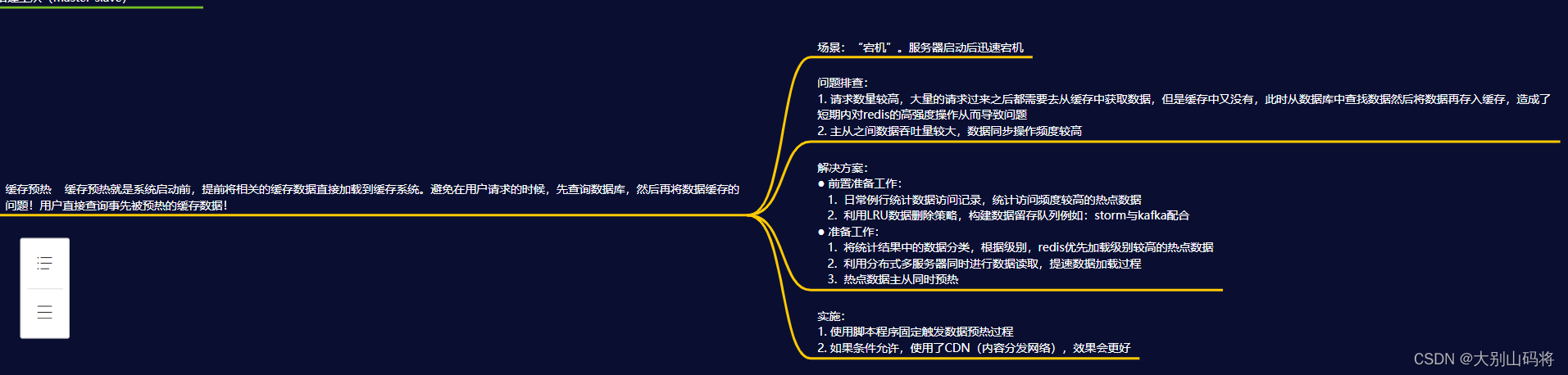

场景:“宕机”

服务器启动后迅速宕机

问题排查:

1.请求数量较高,大量的请求过来之后都需要去从缓存中获取数据,但是缓存中又没有,此时从数据库中查找数据然后将数据再存入缓存,造成了短期内对redis的高强度操作从而导致问题

2.主从之间数据吞吐量较大,数据同步操作频度较高

解决方案:

- 前置准备工作:

- 日常例行统计数据访问记录,统计访问频度较高的热点数据

- 利用LRU数据删除策略,构建数据留存队列例如:storm与kafka配合

- 准备工作:

- 将统计结果中的数据分类,根据级别,redis优先加载级别较高的热点数据

- 利用分布式多服务器同时进行数据读取,提速数据加载过程

- 热点数据主从同时预热

- 实施:

- 使用脚本程序固定触发数据预热过程

- 如果条件允许,使用了CDN(内容分发网络),效果会更好

总的来说:缓存预热就是系统启动前,提前将相关的缓存数据直接加载到缓存系统。避免在用户请求的时候,先查询数据库,然后再将数据缓存的问题!用户直接查询事先被预热的缓存数据!

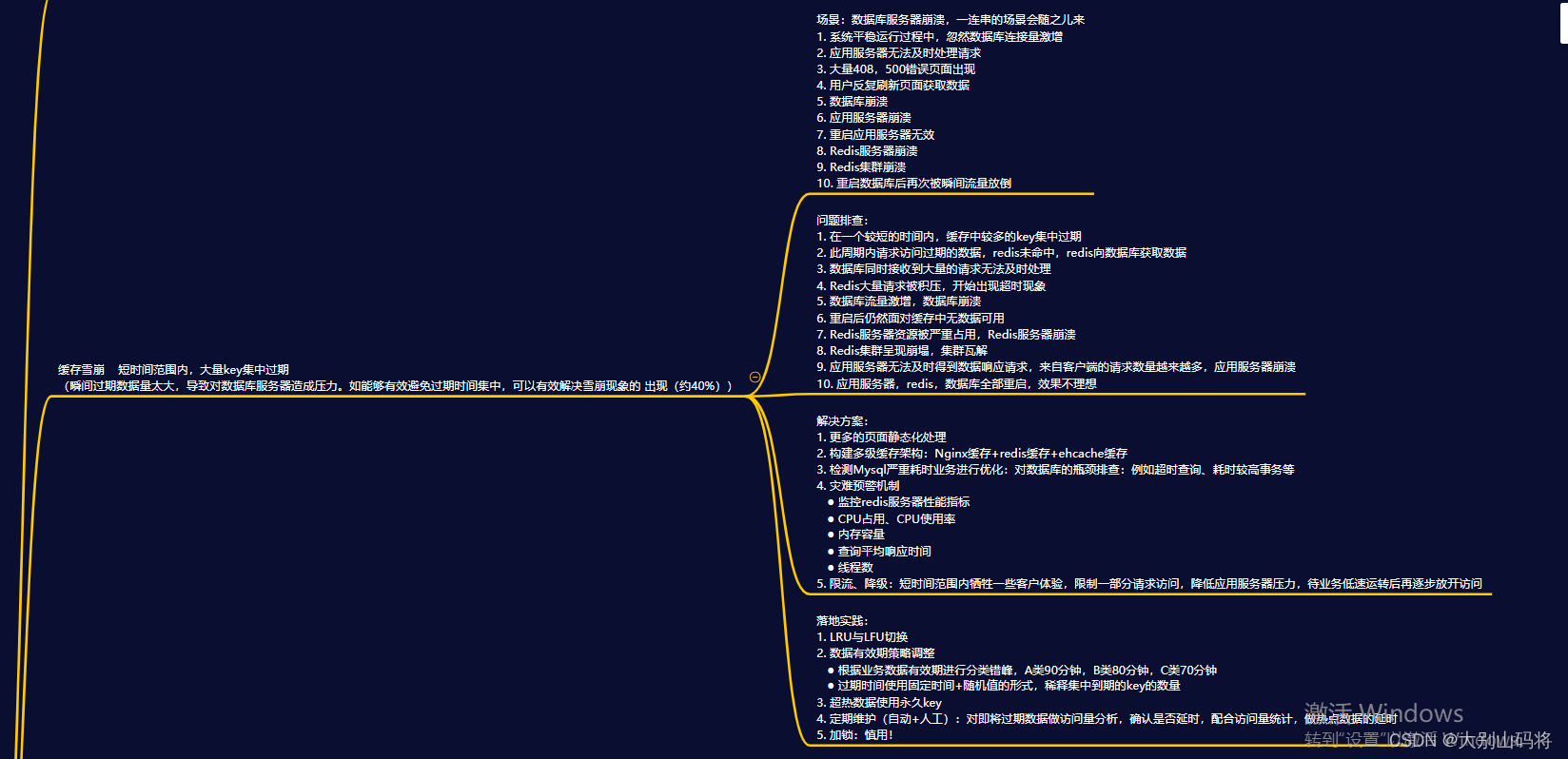

5.2 缓存雪崩

场景:数据库服务器崩溃,一连串的场景会随之儿来

-

系统平稳运行过程中,忽然数据库连接量激增

-

应用服务器无法及时处理请求

-

大量408,500错误页面出现

-

用户反复刷新页面获取数据

-

数据库崩溃

-

应用服务器崩溃

-

重启应用服务器无效

-

Redis服务器崩溃

-

Redis集群崩溃

-

重启数据库后再次被瞬间流量放倒

问题排查:

-

在一个较短的时间内,缓存中较多的key集中过期

-

此周期内请求访问过期的数据,redis未命中,redis向数据库获取数据

-

数据库同时接收到大量的请求无法及时处理

-

Redis大量请求被积压,开始出现超时现象

-

数据库流量激增,数据库崩溃

-

重启后仍然面对缓存中无数据可用

-

Redis服务器资源被严重占用,Redis服务器崩溃

-

Redis集群呈现崩塌,集群瓦解

-

应用服务器无法及时得到数据响应请求,来自客户端的请求数量越来越多,应用服务器崩溃

-

应用服务器,redis,数据库全部重启,效果不理想

总而言之就两点:短时间范围内,大量key集中过期

解决方案

- 思路:

1.更多的页面静态化处理

2.构建多级缓存架构

Nginx缓存+redis缓存+ehcache缓存

3.检测Mysql严重耗时业务进行优化

对数据库的瓶颈排查:例如超时查询、耗时较高事务等

4.灾难预警机制

- 监控redis服务器性能指标

- CPU占用、CPU使用率

- 内存容量

- 查询平均响应时间

- 线程数

5.限流、降级

短时间范围内牺牲一些客户体验,限制一部分请求访问,降低应用服务器压力,待业务低速运转后再逐步放开访问

落地实践:

1.LRU与LFU切换

2.数据有效期策略调整

- 根据业务数据有效期进行分类错峰,A类90分钟,B类80分钟,C类70分钟

- 过期时间使用固定时间+随机值的形式,稀释集中到期的key的数量

3.超热数据使用永久key

4.定期维护(自动+人工)

对即将过期数据做访问量分析,确认是否延时,配合访问量统计,做热点数据的延时

5.加锁:慎用!

总的来说:缓存雪崩就是瞬间过期数据量太大,导致对数据库服务器造成压力。如能够有效避免过期时间集中,可以有效解决雪崩现象的 出现(约40%),配合其他策略一起使用,并监控服务器的运行数据,根据运行记录做快速调整。

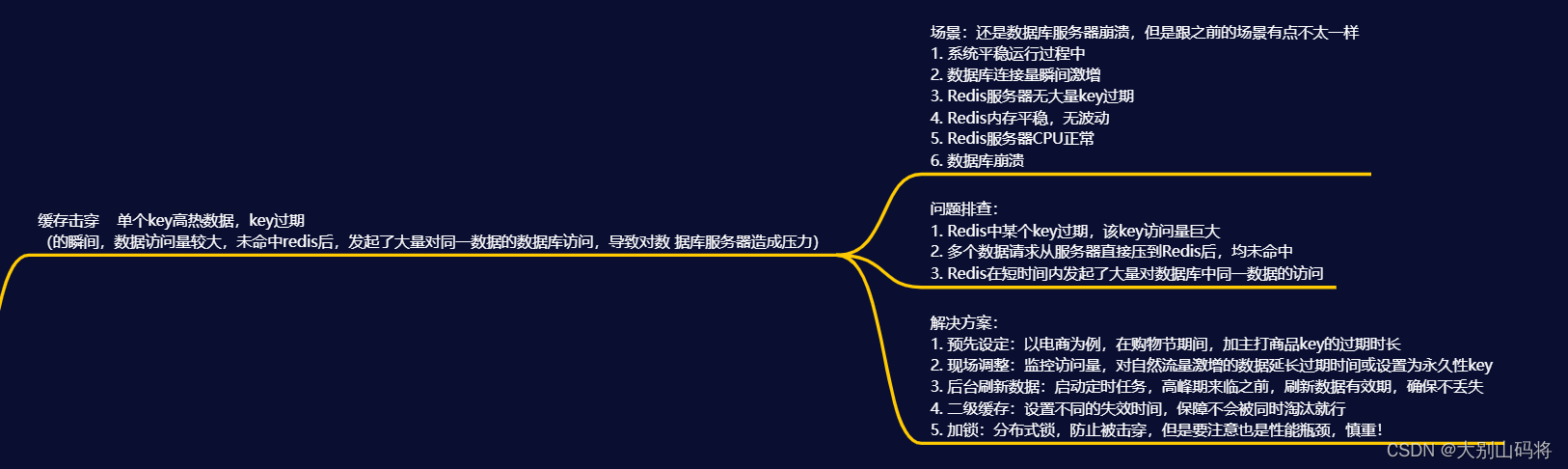

5.3 缓存击穿

场景:还是数据库服务器崩溃,但是跟之前的场景有点不太一样

-

系统平稳运行过程中

-

数据库连接量瞬间激增

-

Redis服务器无大量key过期

-

Redis内存平稳,无波动

-

Redis服务器CPU正常

-

数据库崩溃

问题排查:

-

Redis中某个key过期,该key访问量巨大

-

多个数据请求从服务器直接压到Redis后,均未命中

-

Redis在短时间内发起了大量对数据库中同一数据的访问

总而言之就两点:单个key高热数据,key过期

解决方案:

1.预先设定

以电商为例,每个商家根据店铺等级,指定若干款主打商品,在购物节期间,加大此类信息key的过期时长 注意:购物节不仅仅指当天,以及后续若干天,访问峰值呈现逐渐降低的趋势

2.现场调整

**监控访问量**,对自然流量激增的数据延长过期时间或设置为永久性key

3.后台刷新数据

启动定时任务,高峰期来临之前,刷新数据有效期,确保不丢失

4.二级缓存

设置不同的失效时间,保障不会被同时淘汰就行

5.加锁

分布式锁,防止被击穿,但是要注意也是性能瓶颈,慎重!

总的来说:缓存击穿就是单个高热数据过期的瞬间,数据访问量较大,未命中redis后,发起了大量对同一数据的数据库访问,导致对数 据库服务器造成压力。应对策略应该在业务数据分析与预防方面进行,配合运行监控测试与即时调整策略,毕竟单个key的过 期监控难度较高,配合雪崩处理策略即可。

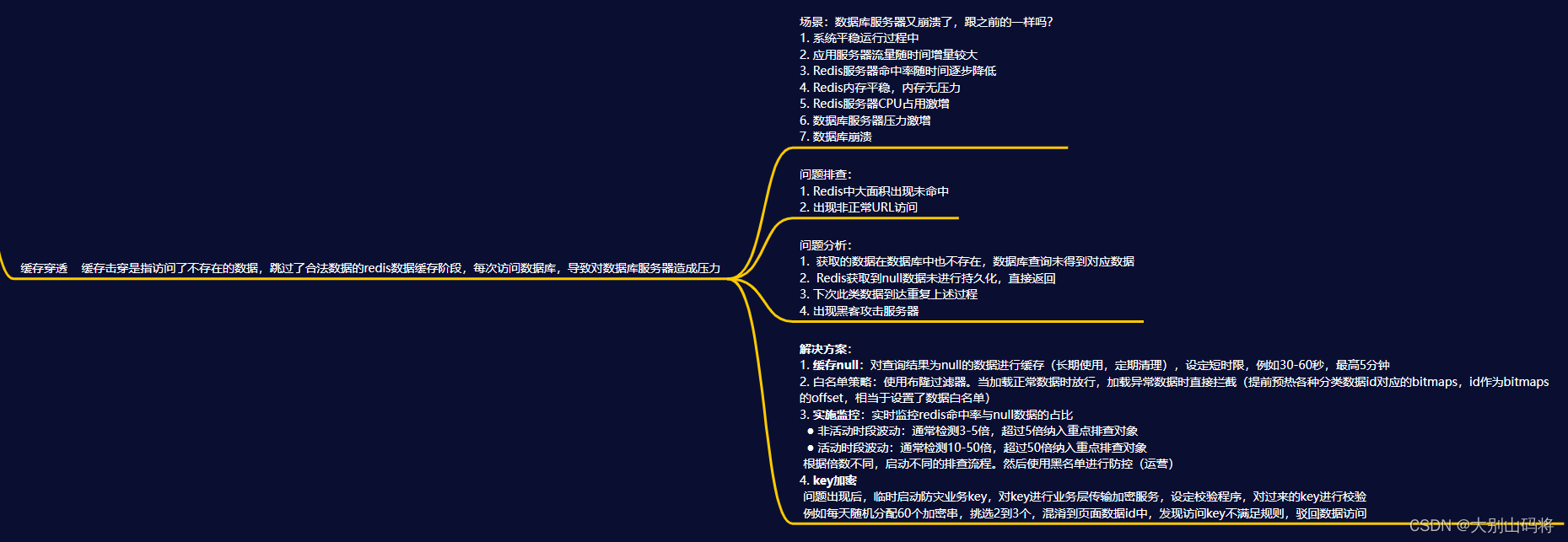

5.4 缓存穿透

场景:数据库服务器又崩溃了,跟之前的一样吗?

-

系统平稳运行过程中

-

应用服务器流量随时间增量较大

-

Redis服务器命中率随时间逐步降低

-

Redis内存平稳,内存无压力

-

Redis服务器CPU占用激增

-

数据库服务器压力激增

-

数据库崩溃

问题排查:

-

Redis中大面积出现未命中

-

出现非正常URL访问

问题分析:

- 获取的数据在数据库中也不存在,数据库查询未得到对应数据

- Redis获取到null数据未进行持久化,直接返回

- 下次此类数据到达重复上述过程

- 出现黑客攻击服务器

解决方案:

1**.缓存null**

对查询结果为null的数据进行缓存(长期使用,定期清理),设定短时限,例如30-60秒,最高5分钟

2.白名单策略

提前预热各种分类数据id对应的bitmaps,id作为bitmaps的offset,相当于设置了数据**白名单**。当加载正常数据时放行,加载异常数据时直接拦截(效率偏低)

使用布隆过滤器(有关布隆过滤器的命中问题对当前状况可以忽略)

2.实施监控

实时监控redis命中率(业务正常范围时,通常会有一个波动值)与null数据的占比

非活动时段波动:通常检测3-5倍,超过5倍纳入重点排查对象 活动时段波动:通常检测10-50倍,超过50倍纳入重点排查对象

根据倍数不同,启动不同的排查流程。然后使用**黑名单**进行防控(运营)

4.key加密

问题出现后,临时启动防灾业务key,对key进行业务层传输加密服务,设定校验程序,过来的key校验

例如每天随机分配60个加密串,挑选2到3个,混淆到页面数据id中,发现访问key不满足规则,驳回数据访问

总的来说:缓存击穿是指访问了不存在的数据,跳过了合法数据的redis数据缓存阶段,每次访问数据库,导致对数据库服务器造成压力。通常此类数据的出现量是一个较低的值,当出现此类情况以毒攻毒,并及时报警。应对策略应该在临时预案防范方面多做文章。

无论是黑名单还是白名单,都是对整体系统的压力,警报解除后尽快移除。

5.5 性能指标监控redis中的监控指标如下:

- 性能指标:Performance

- 响应请求的平均时间:

- 平均每秒处理请求总数

- 缓存查询命中率(通过查询总次数与查询得到非nil数据总次数计算而来)

latency

instantaneous_ops_per_sec

hit_rate(calculated)

- 内存指标:Memory

- 当前内存使用量

- 内存碎片率(关系到是否进行碎片整理)

- 为避免内存溢出删除的key的总数量

- 基于阻塞操作(BLPOP等)影响的客户端数量

used_memory

mem_fragmentation_ratio

evicted_keys

blocked_clients

- 基本活动指标:Basic_activity

- 当前客户端连接总数

- 当前连接slave总数

- 最后一次主从信息交换距现在的秒

- key的总数

connected_clients

connected_slaves

master_last_io_seconds_ago

keyspace

- 持久性指标:Persistence

- 当前服务器最后一次RDB持久化的时间

- 当前服务器最后一次RDB持久化后数据变化总量

rdb_last_save_time

rdb_changes_since_last_save

- 错误指标:Error

- 被拒绝连接的客户端总数(基于达到最大连接值的因素)

- key未命中的总次数

- 主从断开的秒数

rejected_connections

keyspace_misses

master_link_down_since_seconds

要对redis的相关指标进行监控,我们可以采用一些用具:

- CloudInsight Redis

- Prometheus

- Redis-stat

- Redis-faina

- RedisLive

- zabbix

也有一些命令工具:

- benchmark

测试当前服务器的并发性能

范例1:50个连接,10000次请求对应的性能

范例2:100个连接,5000次请求对应的性能

redis-benchmark [-h ] [-p ] [-c ] [-n [-k ]

redis-benchmark

redis-benchmark -c 100 -n 5000

- redis-cli monitor:启动服务器调试信息

monitor

slowlog:慢日志

获取慢查询日志

get :获取慢查询日志信息

len :获取慢查询日志条目数

reset :重置慢查询日志

相关配置

slowlog [operator]

slowlog-log-slower-than 1000 #设置慢查询的时间下线,单位:微妙

slowlog-max-len 100 #设置慢查询命令对应的日志显示长度,单位:命令数