系统:Deepin 系统 Debian内核

1 安装Java JDK查看是否安装了java环境

java -version

如果没有安装 安装方法:https://zhuanlan.zhihu.com/p/343227137

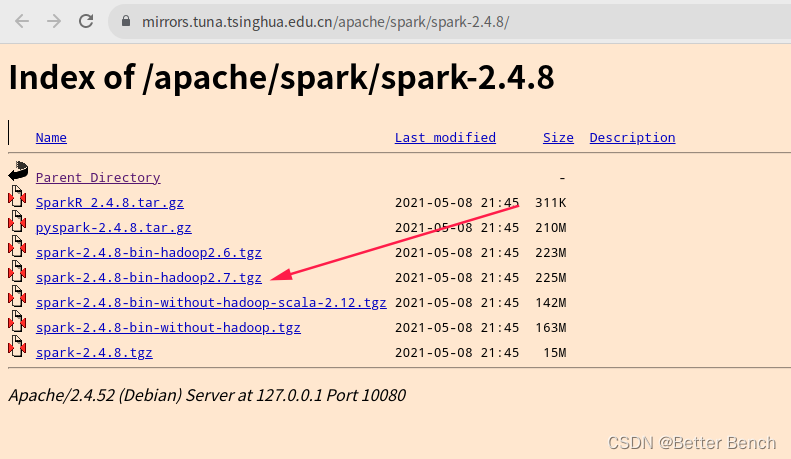

2 下载安装包清华镜像下载,快速:https://mirrors.tuna.tsinghua.edu.cn/apache/spark/spark-2.4.8/  解压命令 tar -zxvf spark-2.4.8-bin-hadoop2.7.tgz

解压命令 tar -zxvf spark-2.4.8-bin-hadoop2.7.tgz

把解压缩的文件夹spark-2.4.8-bin-hadoop2.7重命名为spark

3 配置环境(1)配置文件vim spark-env.sh

cd spark/conf mv spark-env.sh.template spark-env.sh

修改配置文件vim spark-env.sh Java_HOME根据自己的电脑安装路径去配置

export JAVA_HOME=/usr/java/jdk1.8.0_201-amd64 export SPARK_MASTER_HOST=192.168.86.134 export SPARK_MASTER_PORT=7077

(2)配置配置slaves mv slaves.template slaves vim slaves 添加:

Worker的IP,根据自己的需要来添加

(3)配置环境变量: 修改配置文件: vim /etc/profile 增加以下内容:

export SPARK_HOME=spark安装路径 export PATH= P A T H : PATH: PATH:SPARK_HOME/bin export PATH= P A T H : PATH: PATH:SPARK_HOME/sbin

刷新:

source /etc/profile

4 启动和关闭(1)启动主节点:

start-master.sh

(2)启动从节点:

start-slaves.sh

(3)启动shell:

spark-shell

(4)通过网页端查看: http://localhost:8080/ Spark中内置有Tomcat,故端口号默认为8080

(5)关闭主节点:

stop-master.sh

(6)关闭从节点:

stop-slaves.sh

5 例子进入spark安装位置, 然后进入spark中的 bin 文件夹 (1)运行: 输入:spark-shell开启spark(scala) 自己生成一个txt文件,放在根目录/1.txt

1 2 3 4 5 6

把输入文件加载进RDD:

val textFile = sc.textFile(“/1.txt”)

MapReduce操作,以work为key,1为value:

val wordCounts = textFile.flatMap(line => line.split(" ")).map(word => (word, 1)).reduceByKey((a, b) => a + b)

查看每个单词出现的次数

wordCounts.collect()

输出: Array[(String, Int)] = Array((6,1), (3,1), (4,1), (1,1), (5,1), (2,1)) (2)运行: ./bin/pyspark (python) 略