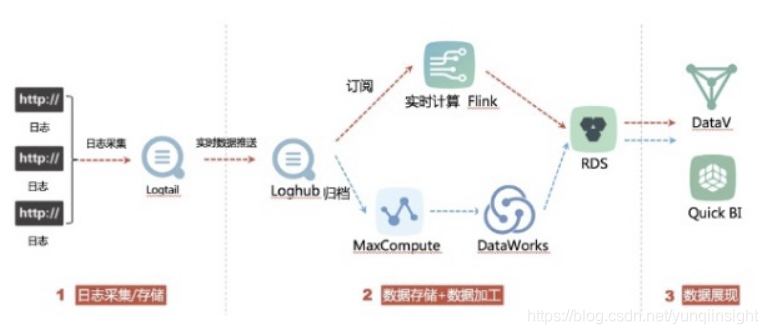

但是会遇到大家在分区上或者DataWorks调度参数配置问题,具体拿到真实的case模拟如下:

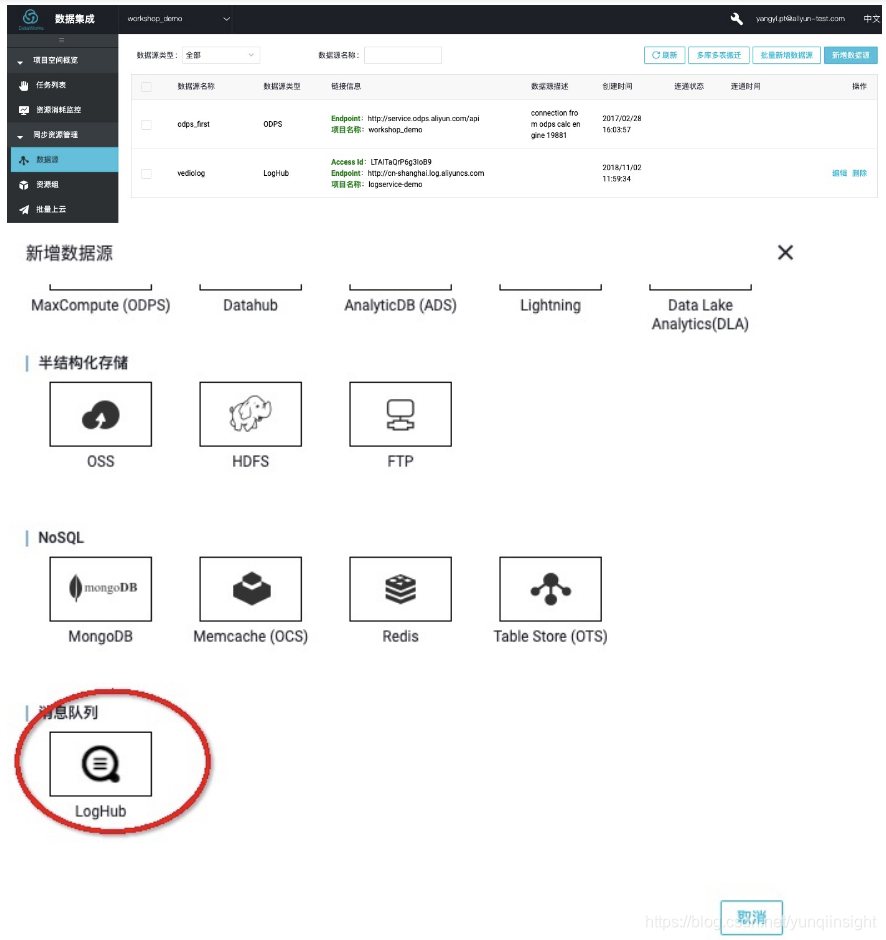

步骤1 进入数据集成,点击作业数据源,进入Tab页面。

步骤2 点击右上角 新增数据源,选择消息队列 loghub。

步骤3 编辑LogHub数据源中的必填项,包括数据源名称、LogHub Endpoint、Project、AK信息等,并点击 测试连通性。

步骤1 在左侧tab也中找到临时查询,并右键>新建ODPS SQL节点。

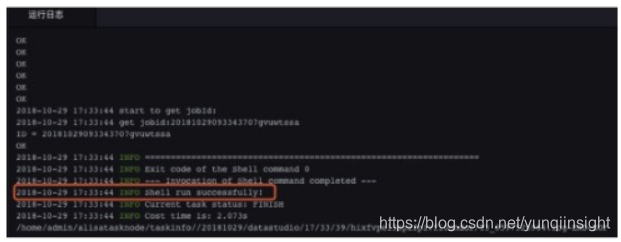

步骤2 编写建表DDL。 步骤3 点击 执行 按钮进行创建目标表,分别为ods_client_operation_log、ods_vedio_server_log、ods_web_tracking_log。

步骤4 直到日志打印成本,表示三条DDL语句执行完毕。

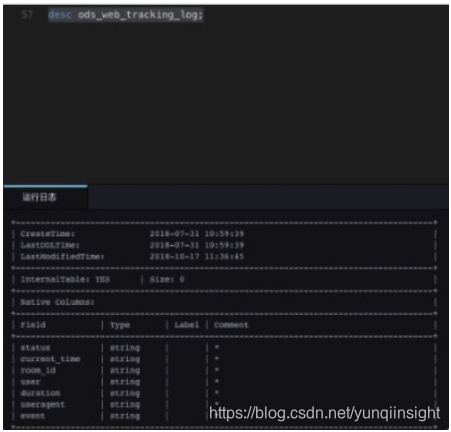

步骤5 可以通过desc 查看创建的表。

其他两张表也可以通过desc 进行查询。确认数据表的存在情况。

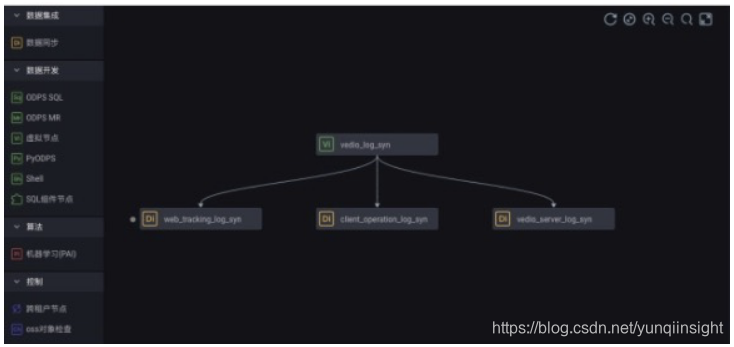

创建数据同步任务数据源端以及在DataWorks中的数据源连通性都已经配置好,接下来就可以通过数据同步任务进行采集数据到MaxCompute上。 操作步骤 步骤1 点击 新建业务流程 并 确认提交,名称为 直播日志采集。

步骤2 在业务流程开发面板中依次创建如下依赖并命名。

依次配置数据同步任务节点配置:web_tracking_log_syn、client_operation_log_syn、vedio_server_log_syn。

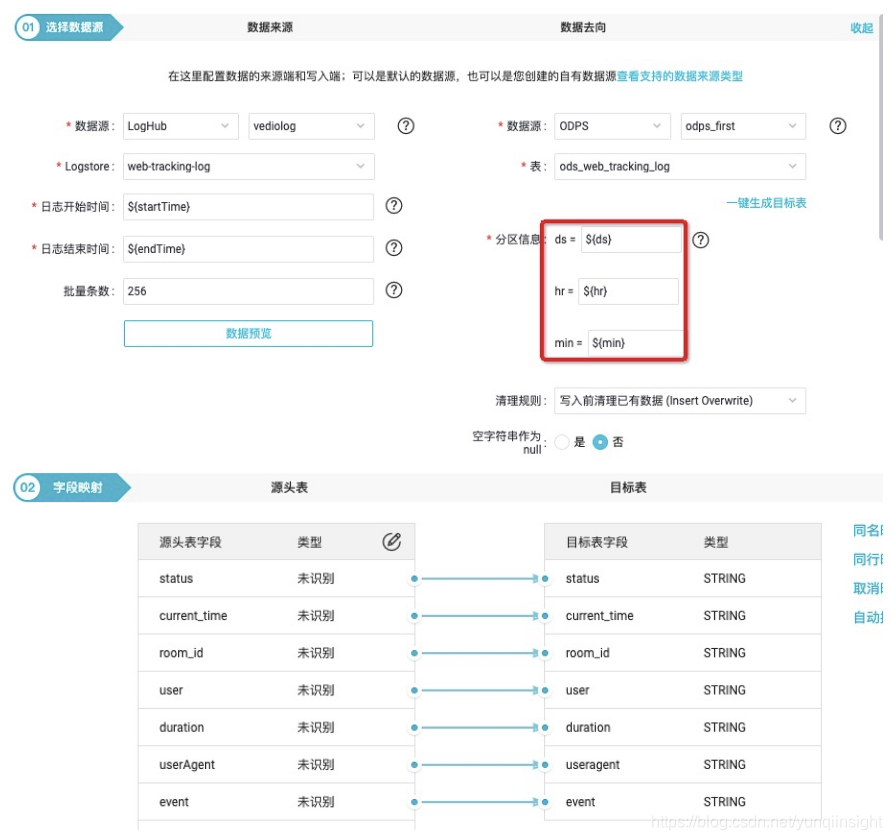

步骤3 双击 web_tracking_log_syn 进入节点配置,配置项包括数据源(数据来源和数据去向)、字段映射(源头表和目标表)、通道控制。

根据采集的时间窗口自定义参数为:

当然其消费点位也可以按照自定义设置5分钟调度一次,从00:00到23:59,startTime=[yyyymmddhh24miss−10/24/60]系统前10分钟到endTime=[yyyymmddhh24miss-5/24/60]系统前5分钟时间(注意与上图消费数据定位不同),那么应该配置为ds=[yyyymmdd-5/24/60],hr=[hh24-5/24/60],min=[mi-5/24/60]。

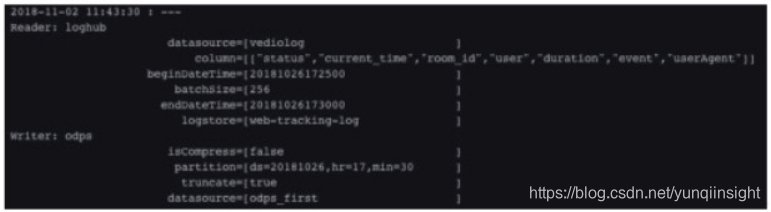

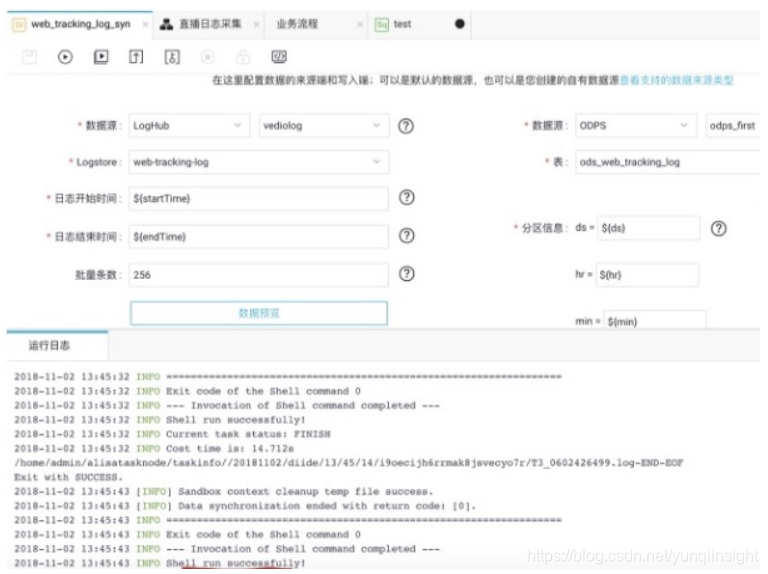

步骤4 可以点击高级运行进行测试。

可以分别手工收入自定义参数值进行测试。

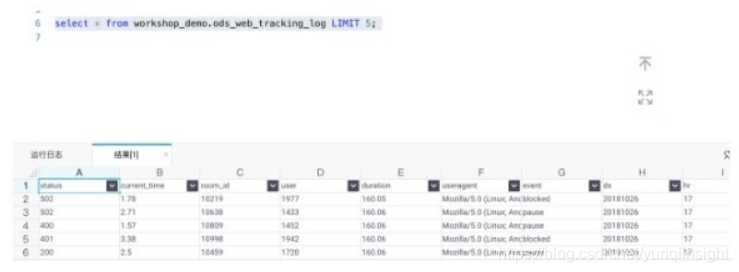

步骤3 使用SQL脚本确认是否数据已经写进来。如下图所示:

日志服务的日志正式的被采集入库,接下来就可以进行数据加工。 比如可以通过上述来统计热门房间、地域分布和卡顿率,如下所示:

具体SQL逻辑不在这里展开,可以根据具体业务需求来统计分析。依赖关系配置如上图所示。

原文链接 本文为云栖社区原创内容,未经允许不得转载。