点击上方“3D视觉工坊”,选择“星标”

干货第一时间送达

本文作者来自 Facebook 和美国罗彻斯特大学,作者提出了一个基于深度学习的光照模型 (Lighting Model),改进当前 3D 人脸追踪对光照条件不够鲁棒的问题,从而捕捉更加细微的面部表情,提高 3D 人脸捕捉的稳定性、贴合度和真实感。

文章方法基于 Deep Appearance Models (DAM) [2],DAM 提出了一种基于深度学习的人脸表达,其变分自编码器 (Variational Auto-encoder, VAE) 来表达 Light Stage 中捕捉的 3D 人脸的几何和外观,其解码器 将编码了表情的隐向量 和表达观察方向 (从人头中心指向相机) 的单位向量 作为输入,输出一个人脸实例:

其中 表示 3D 人脸网格 (几何), 是视角相关的纹理。本文假设目标对象的 DAM 解码器预训练模型已知,提出了一个方法使用该模型拟合图片。这其中的挑战在于,DAM 是在光照可控的实验室环境采集的数据并训练的模型,但最终在应用阶段光照条件是多种多样且不断变换的,如何解决这其中的光照差异。

文章方法的流程如下图 2 所示,作者提出了一个光照模型 (Lighting Model) 来改进 DAM,使得在光照复杂、不受控的环境下也能进行高精度的 3D 人脸追踪。作者启发自[3],通过和 DAM 纹理图尺寸 一致的增益图 (Gain Map) 和偏置图 (Bias Map) 来表达光照变化:

这里 表示逐元素乘积, 表示打光后的纹理, 表示 DAM 模型的原始纹理。增益和偏置图依赖光照、头部姿态、观察视角和人脸表情,这些输入表示为 、 (由头部旋转 和相机视角 组成) 和 ,经过 MLP 处理后和 DAM 的纹理图拼接在一起再通过卷积运算得到最终的打光后的纹理图。即光照模型的表达如下:

其中 表示网络 的权重。

Overview

Face Tracking

Overview

Face Tracking

上述模型训练好后,便可以通过合成分析法 (analysis-by-synthesis) 将人脸模型拟合到光照不受控的 in-the-wild 视频。为了提高鲁棒性和准确性,作者通过如下三个步骤来进行拟合,每个步骤分别解决初始化、准确性和计算效率问题。

Face Tracking

Step 1:Initialization

Face Tracking

Step 1:Initialization

初始化阶段通过极小化人脸关键点的重投影误差来得到初始人脸参数 :

其中 是投影运算, 是由表情隐变量 计算得到的人脸网格。

Step 2: Lighting Model Adaptation前面训练的人脸模型能够合成人脸光照的变换,但使用 light-stage 来模拟真实世界的光照仍然非常具有难度,为了提高光照模型 的表达能力,除了求解光照参数 ,作者来对网络权重 进行微调,在前 帧数据极小化如下损失函数:

这里 是图片差异, 是前景 mask, 是拉普拉斯算子。

Step 3: Face Tracking一旦光照模型适应了当前视频,参数 便可以脱离 估计出来,因此作者只用前 帧数据微调光照模型,然后再估计每一帧的人脸参数。为了提高精确性,除了 Step 2 中的损失,作者在此阶段还加入渲染的模型和图片之间的稠密光流 (dense optical flow) 作为约束:

作者使用 Step 1 计算的初始值,通过极小化损失函数 来优化每一帧的人脸参数 。下图展示了这三个步骤对结果带来的改善。

Result of Each Step

Results

Result of Each Step

Results

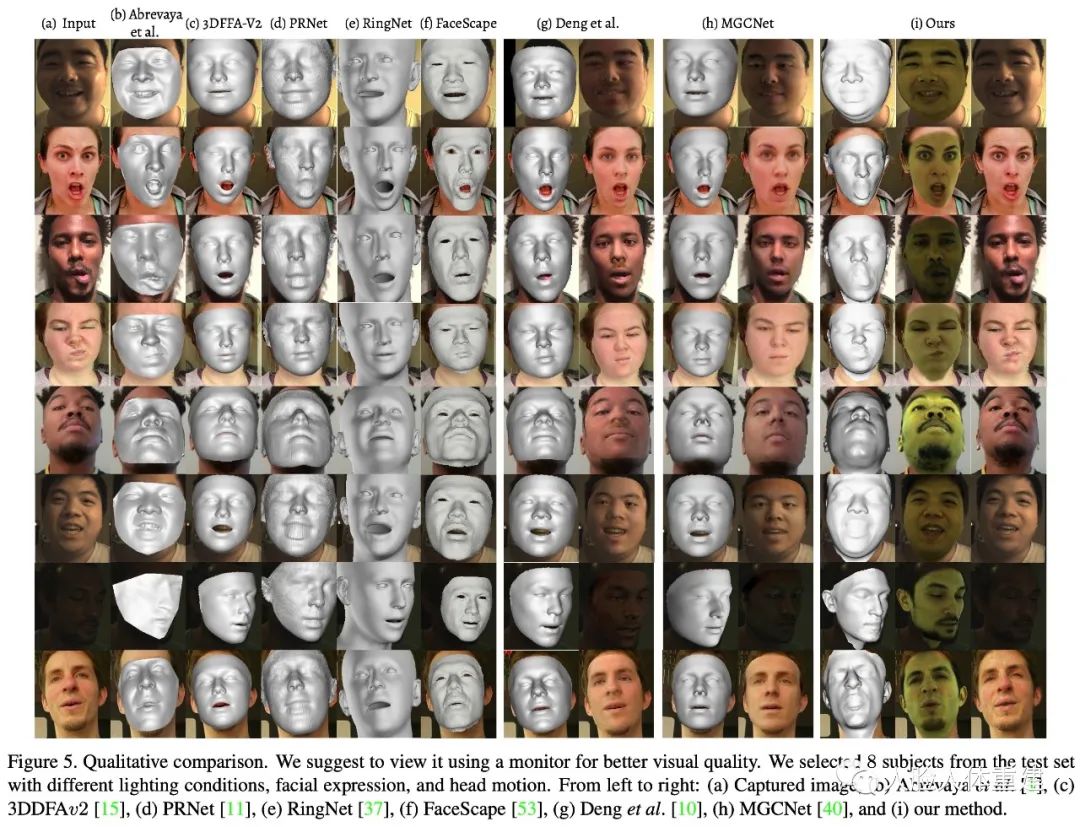

下图展示了文章方法和当前其他一些方法的对比结果,文章方法得到的光照、表情、头部姿态更加准确,通过视频观看更容易看出效果差异。

下图展示了文章方法的结果和使用球谐光 (Spherical Harmonics, SH) 作为光照模型的对比结果,文章方法得到的结果更加真实图片。

-

High-fidelity Face Tracking for AR/VR via Deep Lighting Adaptation. Lele Chen, Chen Cao, Fernando De la Torre, Jason Saragih, Chenliang Xu, Yaser Sheikh. CVPR, 2021.

-

Deep Appearance Models for Face Rendering. Stephen Lombardi, Jason Saragih, Tomas Simon, Yaser Sheikh. SIGGRAPH, 2018.

-

Learning Physics-guided Face Relighting under Directional Light. Thomas Nestmeyer, Jean-François Lalonde, Iain Matthews, Andreas M. Lehrmann. CVPR (Oral), 2020.

本文仅做学术分享,如有侵权,请联系删文。

下载1

在「3D视觉工坊」公众号后台回复:3D视觉,即可下载 3D视觉相关资料干货,涉及相机标定、三维重建、立体视觉、SLAM、深度学习、点云后处理、多视图几何等方向。

下载2

在「3D视觉工坊」公众号后台回复:3D视觉github资源汇总,即可下载包括结构光、标定源码、缺陷检测源码、深度估计与深度补全源码、点云处理相关源码、立体匹配源码、单目、双目3D检测、基于点云的3D检测、6D姿态估计源码汇总等。

下载3

在「3D视觉工坊」公众号后台回复:相机标定,即可下载独家相机标定学习课件与视频网址;后台回复:立体匹配,即可下载独家立体匹配学习课件与视频网址。

重磅!3DCVer-学术论文写作投稿 交流群已成立

扫码添加小助手微信,可申请加入3D视觉工坊-学术论文写作与投稿 微信交流群,旨在交流顶会、顶刊、SCI、EI等写作与投稿事宜。

同时也可申请加入我们的细分方向交流群,目前主要有3D视觉、CV&深度学习、SLAM、三维重建、点云后处理、自动驾驶、多传感器融合、CV入门、三维测量、VR/AR、3D人脸识别、医疗影像、缺陷检测、行人重识别、目标跟踪、视觉产品落地、视觉竞赛、车牌识别、硬件选型、学术交流、求职交流、ORB-SLAM系列源码交流、深度估计等微信群。

一定要备注:研究方向+学校/公司+昵称,例如:”3D视觉 + 上海交大 + 静静“。请按照格式备注,可快速被通过且邀请进群。原创投稿也请联系。

▲长按加微信群或投稿

▲长按关注公众号

3D视觉从入门到精通知识星球:针对3D视觉领域的视频课程(三维重建系列、三维点云系列、结构光系列、手眼标定、相机标定、orb-slam3等视频课程)、知识点汇总、入门进阶学习路线、最新paper分享、疑问解答五个方面进行深耕,更有各类大厂的算法工程人员进行技术指导。与此同时,星球将联合知名企业发布3D视觉相关算法开发岗位以及项目对接信息,打造成集技术与就业为一体的铁杆粉丝聚集区,近2000星球成员为创造更好的AI世界共同进步,知识星球入口:

学习3D视觉核心技术,扫描查看介绍,3天内无条件退款

圈里有高质量教程资料、可答疑解惑、助你高效解决问题

觉得有用,麻烦给个赞和在看~