目录

文章信息

HIRE

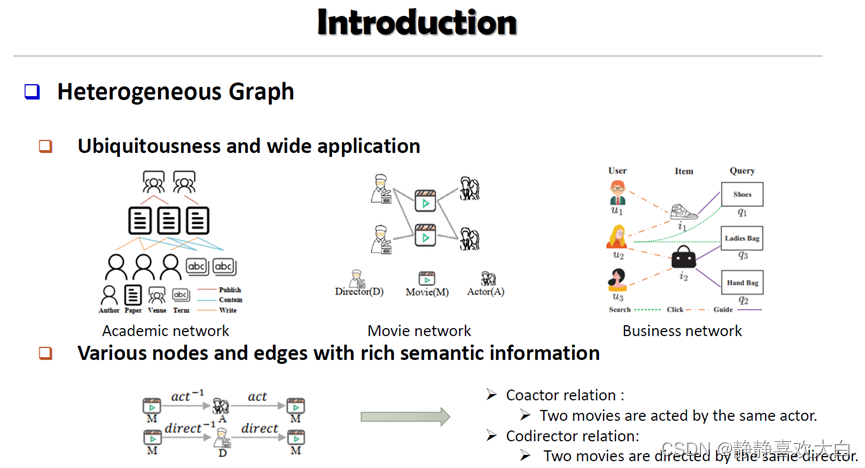

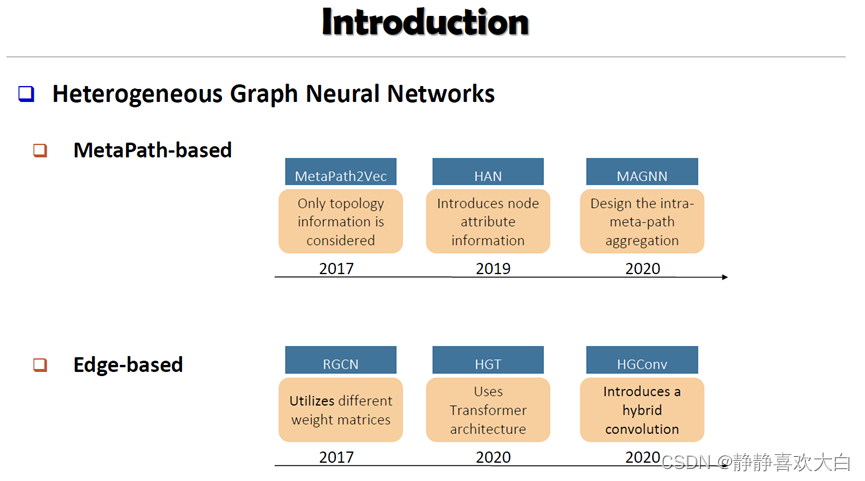

简介

背景

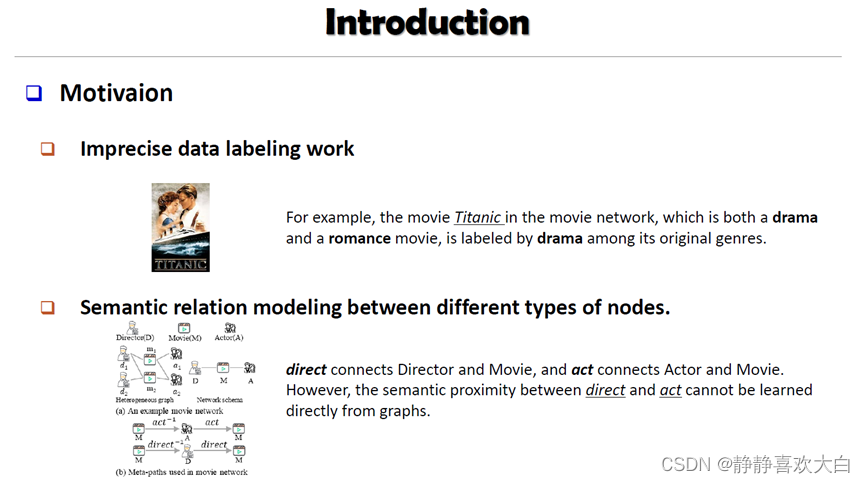

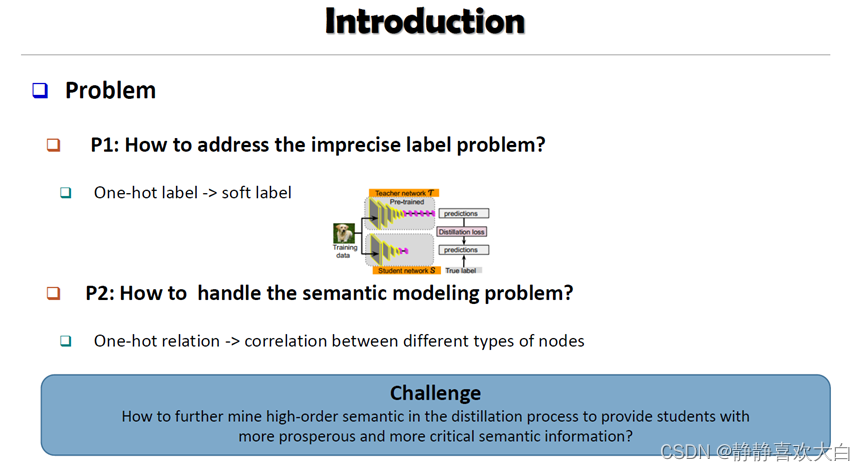

动机

挑战

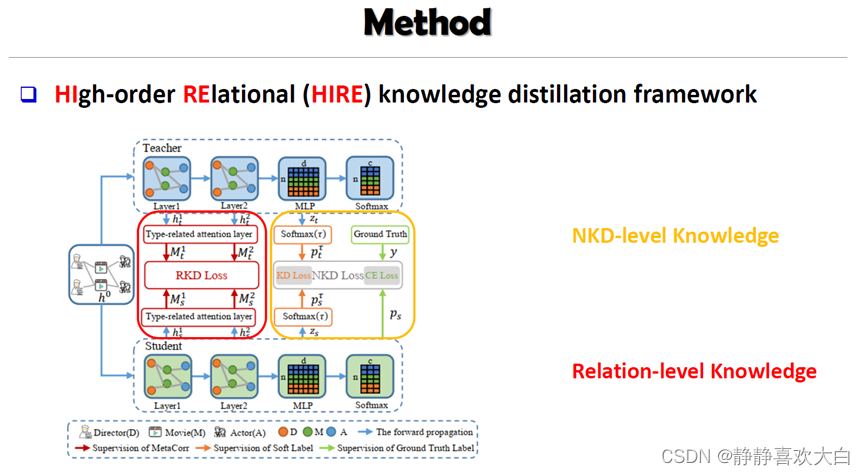

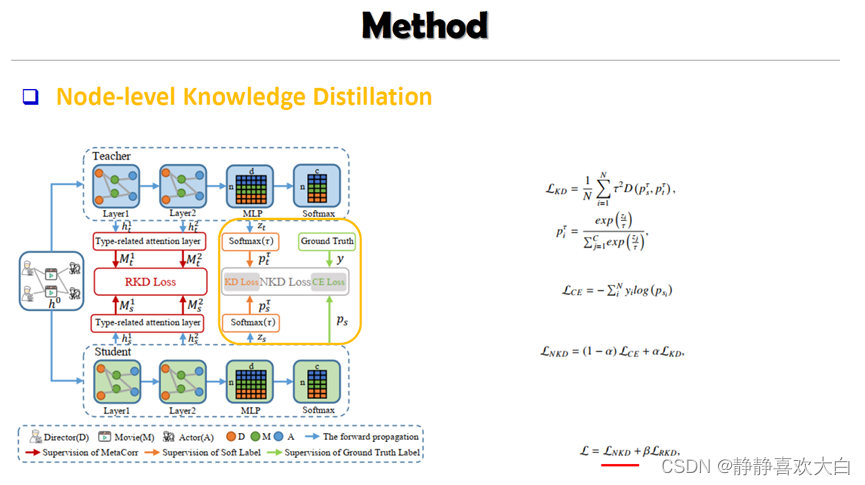

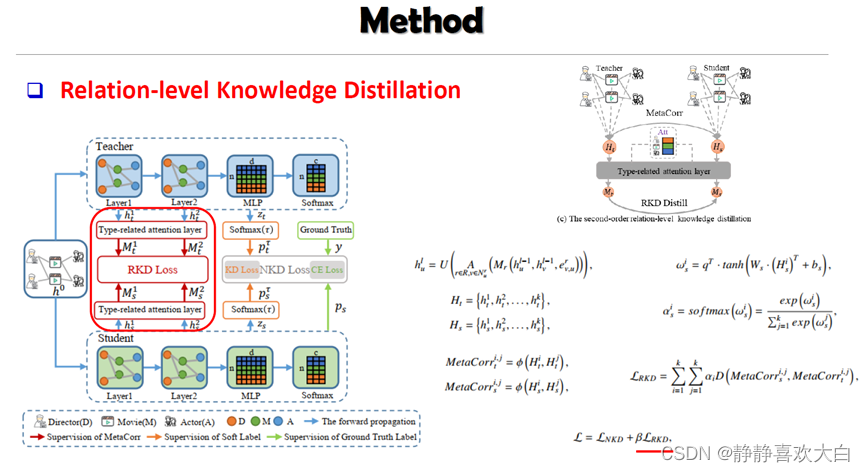

方法

NKD

RKD

实验

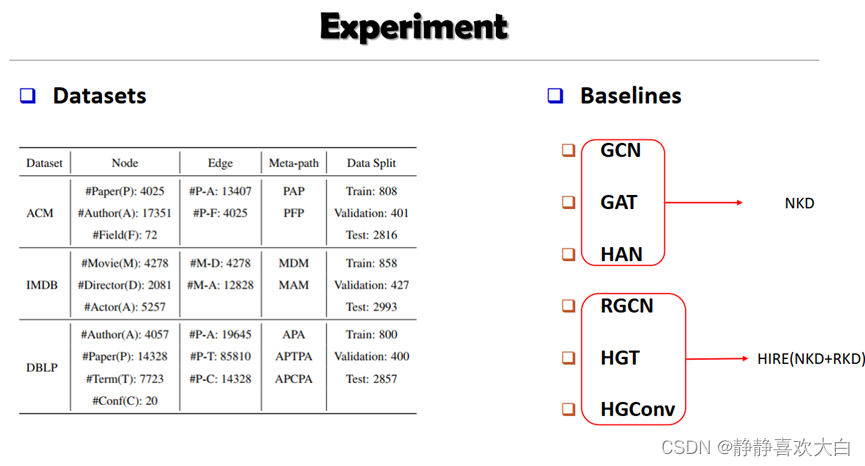

实验设置

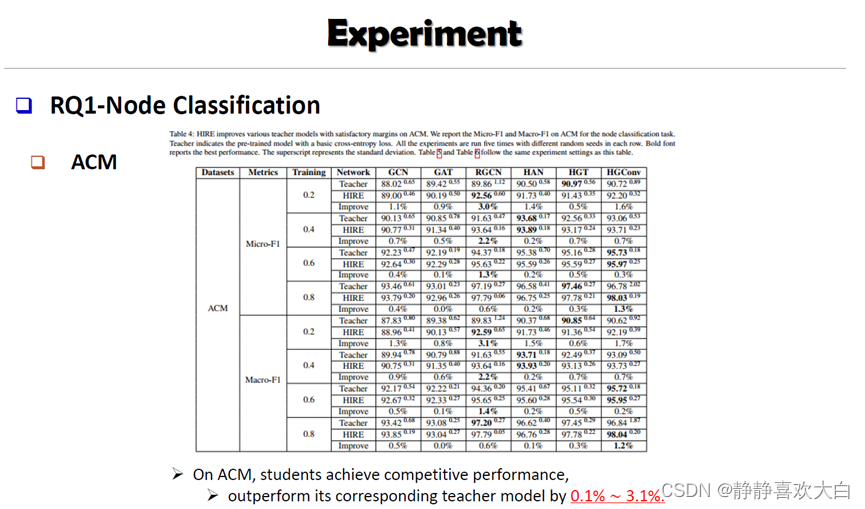

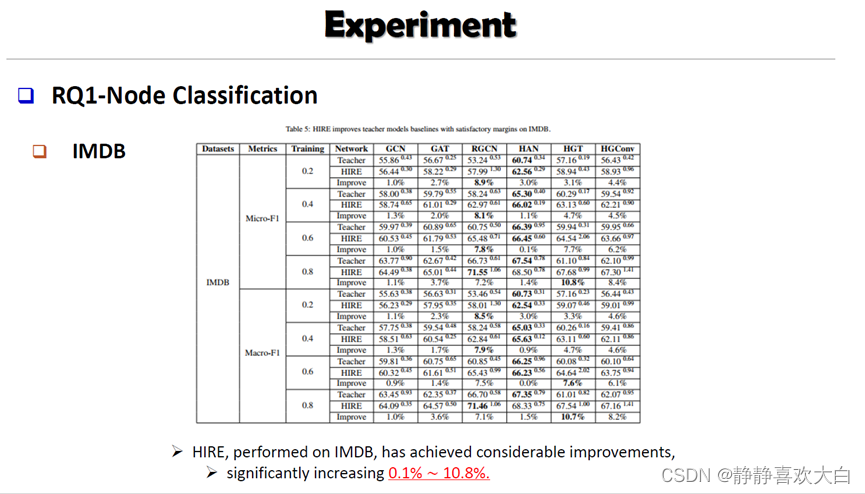

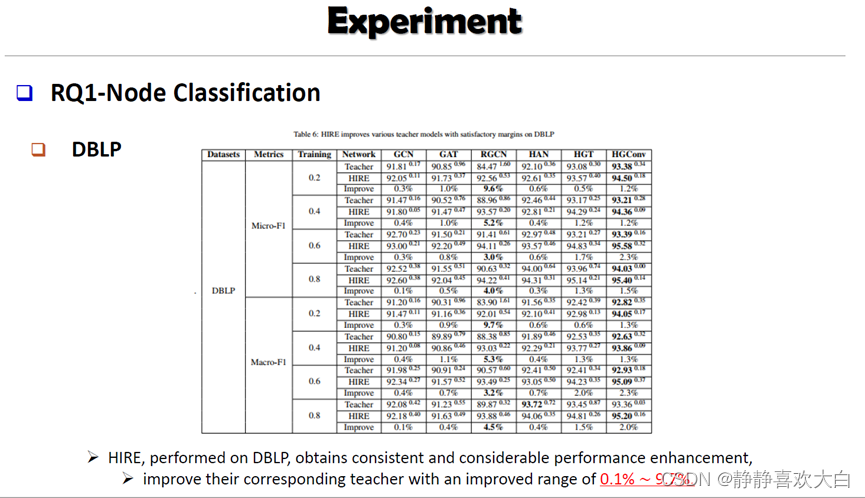

节点分类

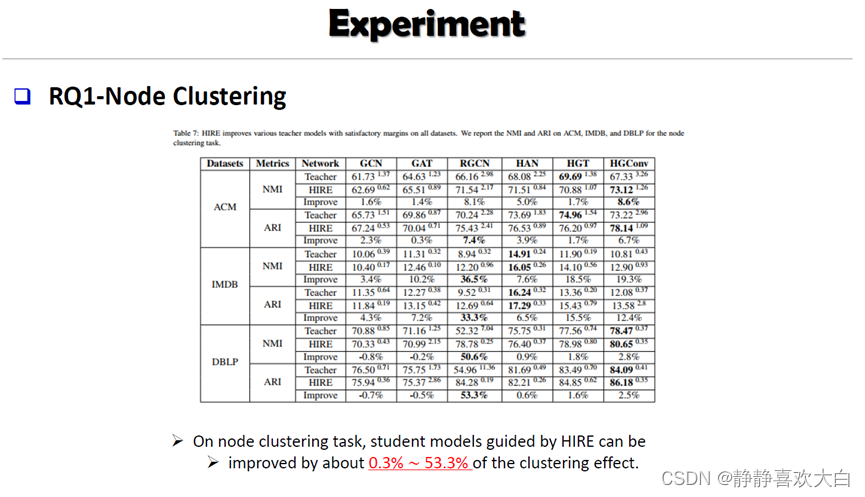

节点聚类

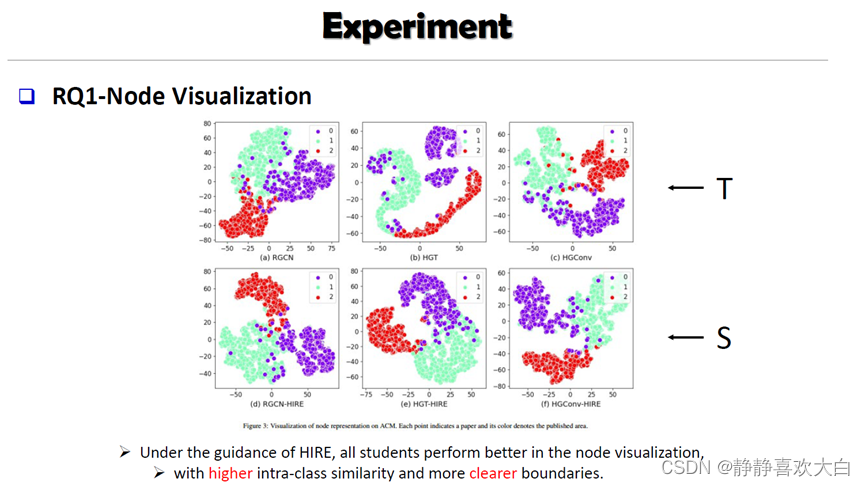

节点可视化

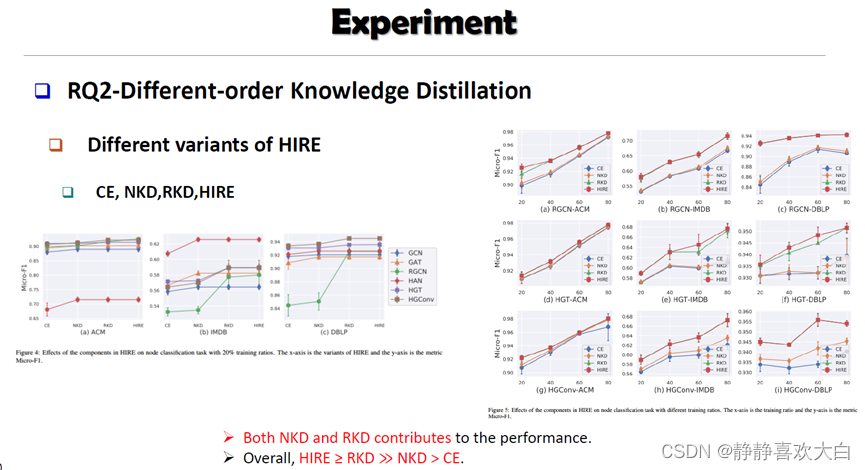

消融实验

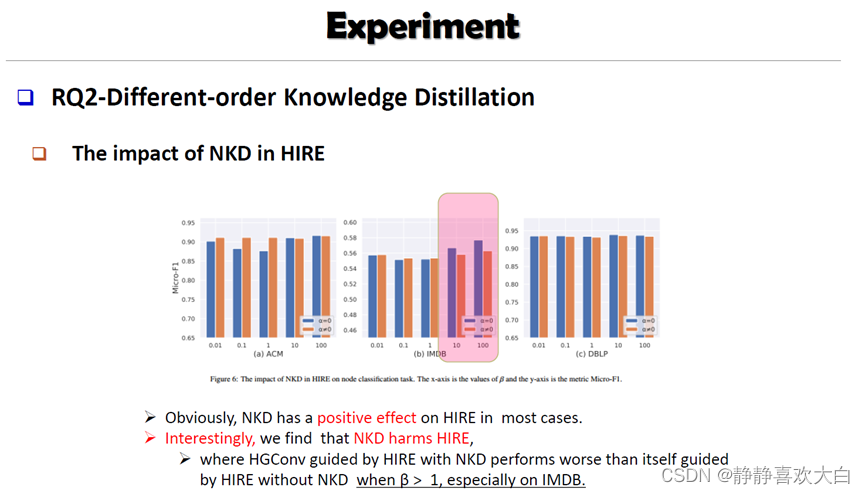

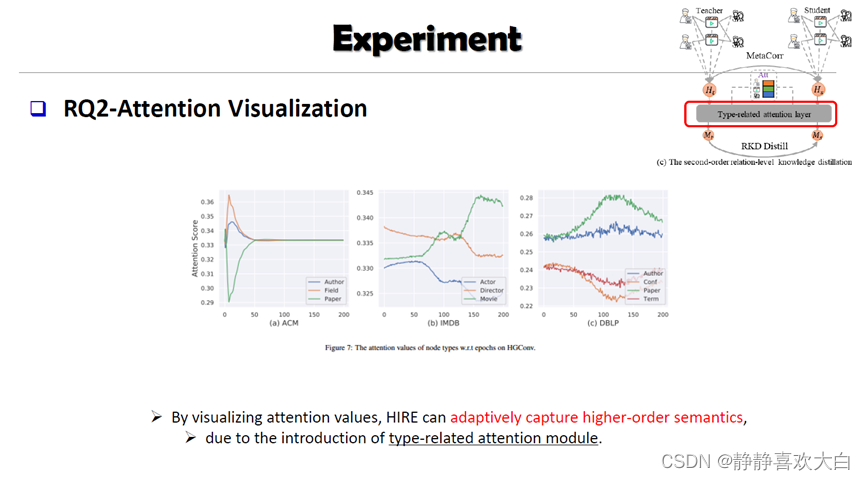

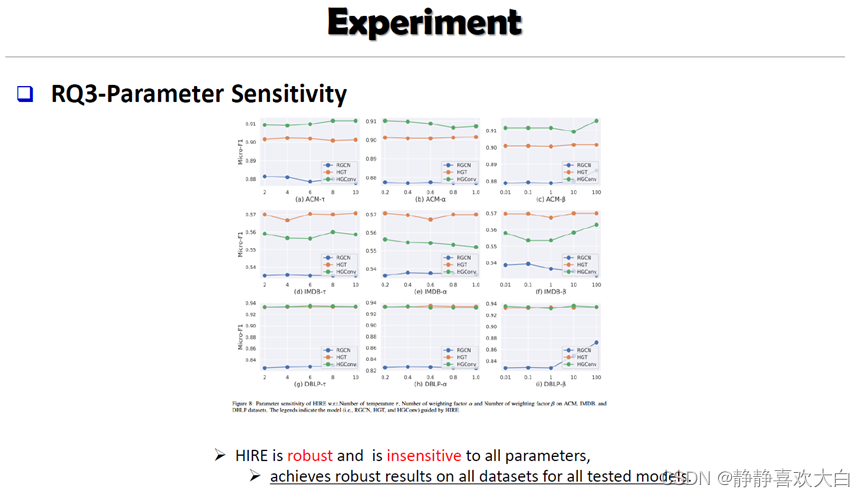

参数敏感性实验

总结

参考文献

文章信息

「来源」:Neurocomputing 2022

「标题」:HIRE: Distilling high-order relational knowledge from heterogeneous graph neural networks

「作者」:Jing Liu, Tongya Zheng, Qinfen Hao

「单位」:中科院计算技术研究所 & 浙江大学

「链接」:https://www.sciencedirect.com/science/article/pii/S0925231222009961

或者https://arxiv.org/abs/2207.11887

「简介」:

由于异构图在学术界和工业界的普遍存在,研究人员最近提出了大量的异构图神经网(HGNN)。与追求更强大的HGNN模型不同,本文更加感兴趣的是设计一个通用的即插即用模块,该模块从预先训练的HGNN中提取相关知识。据我们所知,本文是首篇提出异构图神经网络上的高阶关系(HIgh-order RElational, HIRE)知识蒸馏框架,该框架可以显著提高异构图神经网络模型的性能。具体来说,该方法通过进行节点级知识蒸馏(Node-level Knowledge Distillation, NKD),对预训练异构教师模型的单个节点语义进行编码;通过进行关系级知识蒸馏(Relation-level Knowledge Distillatio, RKD),对预训练异构教师模型的不同类型节点之间的语义关系进行建模。通过整合节点级知识蒸馏和系级知识蒸馏, 这种高阶关系知识蒸馏方法成为一种实用且通用的训练方法,适用于任意的异构图神经网络,不仅提升了异构学生模型的性能和泛化能力,而且保证了对异构图神经网络的节点级和关系级知识提取。

HIRE

Liu, J., Zheng, T., & Hao, Q. (2022). HIRE: Distilling High-order Relational Knowledge From Heterogeneous Graph Neural Networks. Neurocomputing, 507, 67-83.

Neurocomputing 2022 | HIRE:首个基于HGNN的即插即用的通用高效知识蒸馏框架