点击上方“3D视觉工坊”,选择“星标”

干货第一时间送达

作者丨paopaoslam@知乎

来源丨 泡泡机器人SLAM

标题:Point 4D Transformer Networks for Spatio-Temporal Modeling in Point Cloud Videos

作者:Hehe Fan,Yi Yang,Mohan Kankanhalli

来源:CVPR 2021

编译:林逸泰

审阅:王志勇

摘要

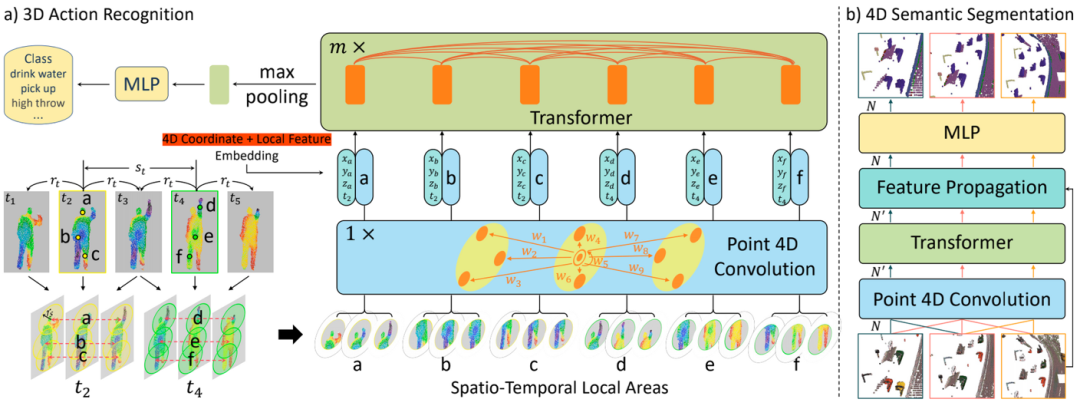

点云视频(Point cloud video)在空间维度上展现了不规则于无序性,不同帧的中点的出现也无法保证一致性。点跟踪常用于捕获点云视频流中的动态信息,但是表示同一位置的点在不同帧中时有时无,使得计算精确的点轨迹非常困难,并且跟踪通常还依赖于点的颜色,因此在缺乏颜色信息的点云中容易失效。本文为了避免点跟踪,提出了新颖的Point 4D Transformer(P4Transformer)以处理原始点云视频。P4Transformer包含了:(i)一个可编码点云视频中的时空局部结构信息的点的4D卷积和 (ii)一个在编码后的局部特征中使用self-attention来捕获整个点云视频的外观和移动信息的的Transformer。照这样,比起显示地点跟踪,相关和相似的局部区域都可以通过注意力权重结合。大量的实验,包括在4个榜单上的3D动作识别和4D语义分割实验,展示了P4Transformer在点云视频处理的有效性。

主要贡献

-

为了避免点跟踪,我们提出了一个基于Transformer的P4Transformer在时空上处理原始点云视频。在我们的知识范围内,我们是第一个将Transformer用于时空点云处理的人。

-

我们提出了点的4D卷积来编码时空局部结构,从而减少Transformer需要处理的数据量。

-

4个数据集上的大量实验表明,我们的P4Transformer大大提高了3D动作识别和4D语义分割的精度。

算法流程

网络结构

4D 卷积

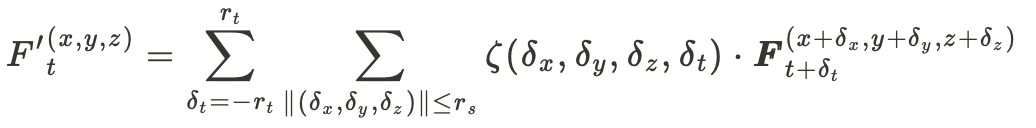

由于点云中点的坐标的连续性和不规则性,本文提出使用函数(zeta)来间接生成卷积核:

zeta函数可以表示为:

W_d是用于时空坐标的权重矩阵,W_f是用于每个点的特征(比如颜色)的权重矩阵,而中间的运算符(cdot)可以是元素级的加,乘等。

时空点云数据的中心轴的构造方法类似PSTNet(ICLR 2021),可以看网络结构图中的左下角,基本流程是:通过在时间上采样部分帧,并在采样的帧中通过FPS在欧氏空间中采样点。得到的中心点再转化到前后的帧中,中心点点时空近邻是通过在时间窗口中的帧采样欧氏空间的近邻得到的。

Transformer

Transformer缺乏位置信息,为了添加位置信息,论文提出将位置信息结合到点云特征中:

其中F为特征,I为Transformer的输入。

Transformer会在整个点云视频上运行以捕获整个视频上的注意力信息,并且使用了多头(Multi-head)机制。

实验

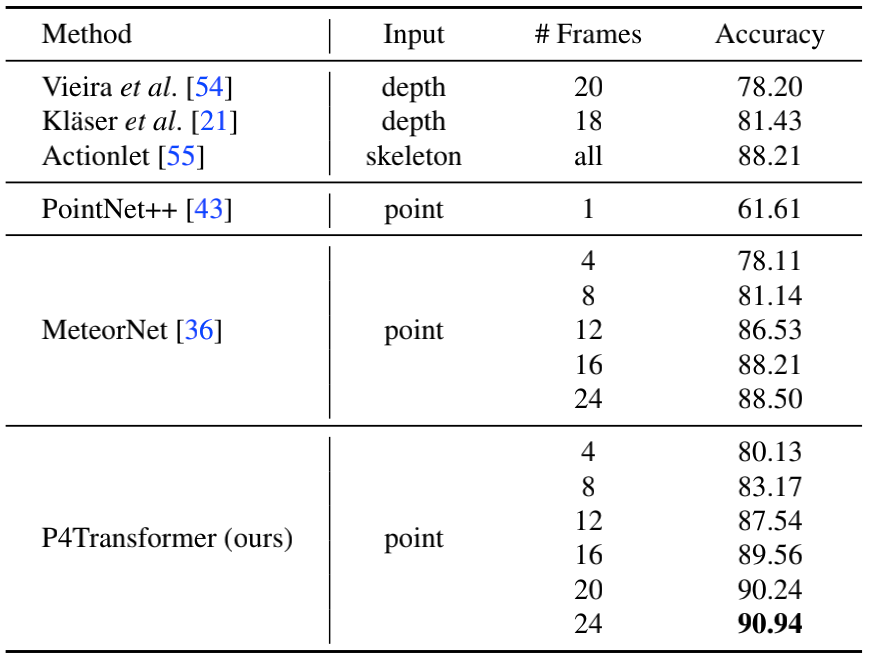

MSR-Action3D的精度

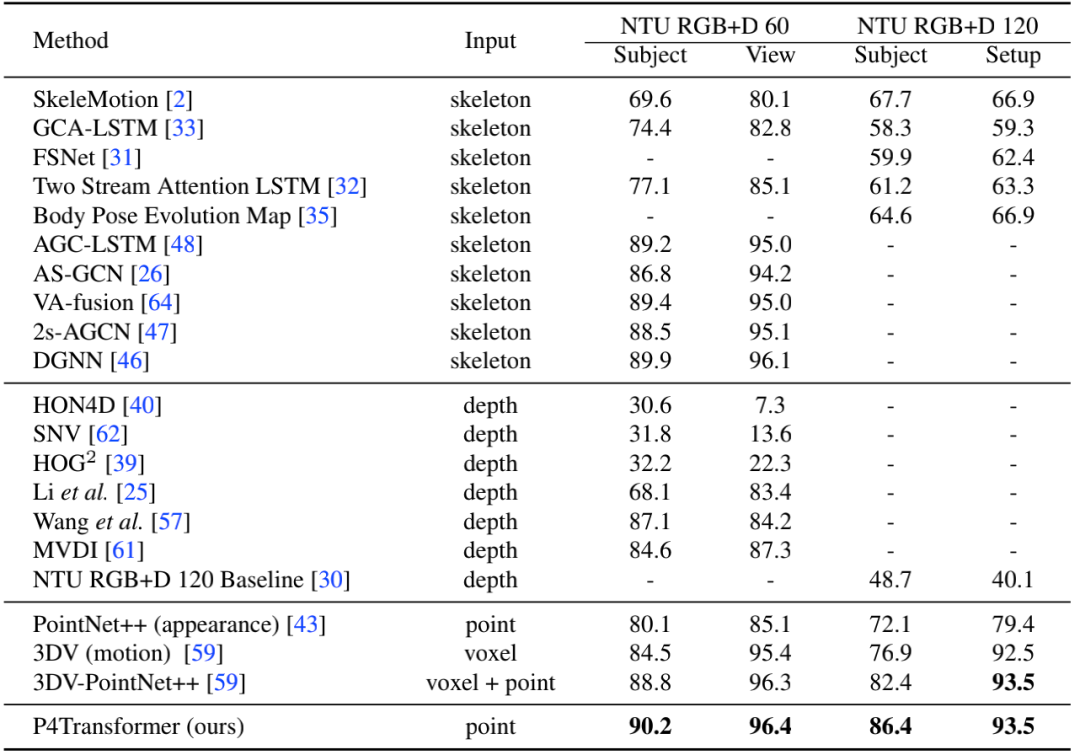

NTU RGB-D 60 和 NTU RGB+D 120上的精度

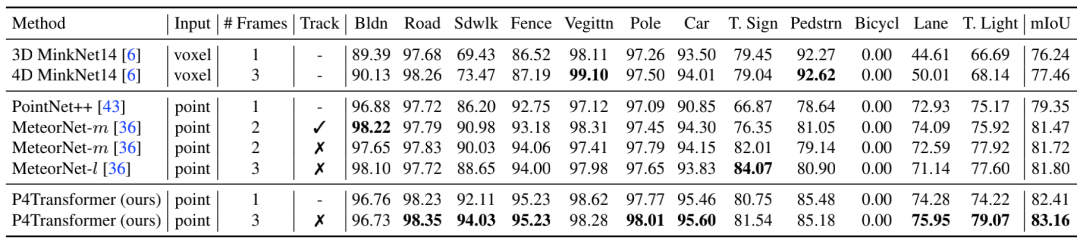

Synthia 4D上的语义分割结果(mIoU)

本文仅做学术分享,如有侵权,请联系删文。

3D视觉精品课程推荐:

1.面向自动驾驶领域的多传感器数据融合技术

2.面向自动驾驶领域的3D点云目标检测全栈学习路线!(单模态+多模态/数据+代码) 3.彻底搞透视觉三维重建:原理剖析、代码讲解、及优化改进 4.国内首个面向工业级实战的点云处理课程 5.激光-视觉-IMU-GPS融合SLAM算法梳理和代码讲解 6.彻底搞懂视觉-惯性SLAM:基于VINS-Fusion正式开课啦 7.彻底搞懂基于LOAM框架的3D激光SLAM: 源码剖析到算法优化 8.彻底剖析室内、室外激光SLAM关键算法原理、代码和实战(cartographer+LOAM +LIO-SAM)

9.从零搭建一套结构光3D重建系统[理论+源码+实践]

10.单目深度估计方法:算法梳理与代码实现

11.自动驾驶中的深度学习模型部署实战

12.相机模型与标定(单目+双目+鱼眼)

重磅!3DCVer-学术论文写作投稿 交流群已成立

扫码添加小助手微信,可申请加入3D视觉工坊-学术论文写作与投稿 微信交流群,旨在交流顶会、顶刊、SCI、EI等写作与投稿事宜。

同时也可申请加入我们的细分方向交流群,目前主要有3D视觉、CV&深度学习、SLAM、三维重建、点云后处理、自动驾驶、多传感器融合、CV入门、三维测量、VR/AR、3D人脸识别、医疗影像、缺陷检测、行人重识别、目标跟踪、视觉产品落地、视觉竞赛、车牌识别、硬件选型、学术交流、求职交流、ORB-SLAM系列源码交流、深度估计等微信群。

一定要备注:研究方向+学校/公司+昵称,例如:”3D视觉 + 上海交大 + 静静“。请按照格式备注,可快速被通过且邀请进群。原创投稿也请联系。

▲长按加微信群或投稿

▲长按关注公众号

3D视觉从入门到精通知识星球:针对3D视觉领域的视频课程(三维重建系列、三维点云系列、结构光系列、手眼标定、相机标定、激光/视觉SLAM、自动驾驶等)、知识点汇总、入门进阶学习路线、最新paper分享、疑问解答五个方面进行深耕,更有各类大厂的算法工程人员进行技术指导。与此同时,星球将联合知名企业发布3D视觉相关算法开发岗位以及项目对接信息,打造成集技术与就业为一体的铁杆粉丝聚集区,近4000星球成员为创造更好的AI世界共同进步,知识星球入口:

学习3D视觉核心技术,扫描查看介绍,3天内无条件退款

圈里有高质量教程资料、答疑解惑、助你高效解决问题

觉得有用,麻烦给个赞和在看~