作者丨半闲@知乎

来源丨https://zhuanlan.zhihu.com/p/477663378

编辑丨3D视觉工坊

论文名称:

Beyond 3D Siamese Tracking: A Motion-Centric Paradigm for 3D Single Object Tracking in Point Clouds

作者信息:

论文地址:https://arxiv.org/abs/2203.01730

代码开源: https://github.com/Ghostish/Open3DSOT

CVPR 2022

与提出BAT算法的是同一团队,BAT算法的解析可见:https://zhuanlan.zhihu.com/p/431290966

1、Motivation目前在3D单目标跟踪领域,大多数方法使用的都是appearence matching(外观匹配)的方式进行跟踪,这种方法非常依赖于模板和搜索区域点云的特征。在KITTI数据集上,apperaence matching的方法,比如BAT、P2B等,都取得了非常良好的效果,但是作者认为这是因为1、KITTI数据集上的被跟踪物体移动速度都不快,这使得其外观是缓慢变化的 2、被跟踪物体周围通常没有干扰物,对物体特征提取的干扰较小。然而,真实世界通常不存在以上两个特点。

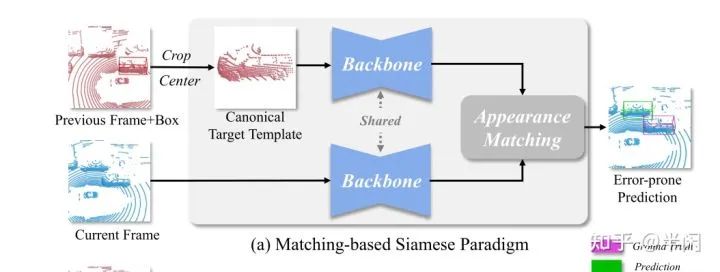

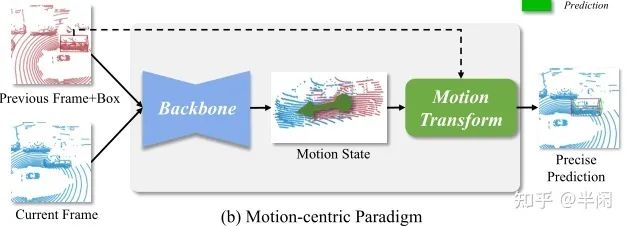

所以,在复杂的现实场景中,单纯的使用apperence matching的方式进行跟踪效果并不好,故作者提出了使用Motion-Centric paradigm(运动估计范式)进行目标跟踪。图1是matching-based的算法的结构图,图2是Motion-centric paradigm的结构图。

图1 Matching-based的范式

图2 Motion-centric的范式

作者认为该文具有以下三个贡献:

1、提出了一个新颖的Motion-Centric paradigm,使用该范式的算法不依赖于外观匹配

2、提出了基于该范式的具体算法MM-Track

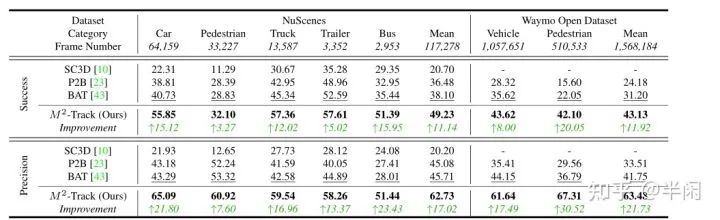

3、提出的算法在KITTI、NuScenes、Waymo Open Dataset数据集上取得了非常好的效果

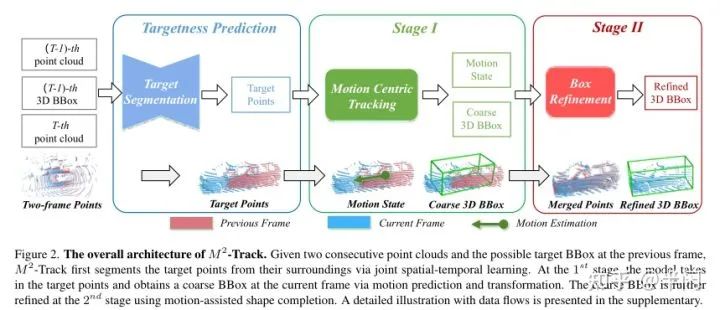

2、Method该文提出的MM-Track算法的结构图如图3所示。

图3 MM-Track 算法结构图

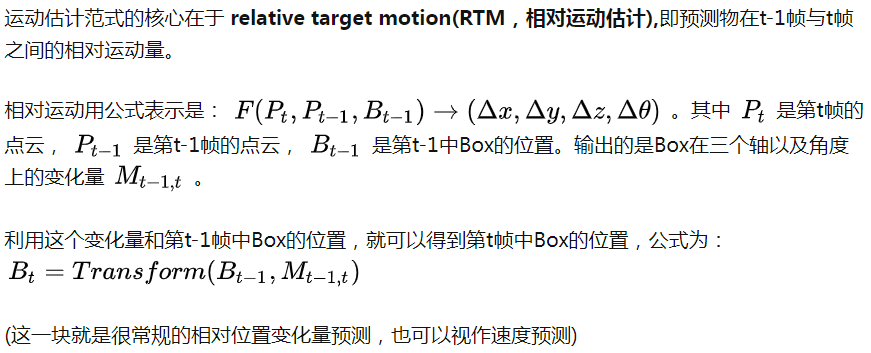

2.1 Motion-Centric paradigm(运动估计范式)

基于2.1中所述的Motion-Centric范式,作者提出了MM-Track算法,该算法是一个两阶段算法。第一阶段通过目标分割(这一步或许也可以看做预处理)、运动估计得到大致的目标框,第二阶段使用motion-assisted shape completion进行目标框优化。

2.2.1使用基于时空特征的目标分割作为预处理:

为了得到目标点的相对位移,那么第一步就应该是将目标点从背景点中分割出来。作者构建了一个所谓的spatial-temporal point cloud(时空信息点云),其实就是把前后两帧的点云拼接在了一起,然后给每个点加了个时间戳。表示为

随后作者为时间信息点云中的每一个点加了一个先验置信度,用公式来说就是:

即,一个点,如果是上一帧的点,并且在Box中,先验置信度为1。如果是上一帧的点,不在Box中,先验置信度为0。如果是这一帧的点,先验置信度为0.5。

这其实也挺好理解,如果在上一帧的Box中,那么该点是前景点的可能性是最大的,如果不在Box中,那么他多半不是前景点。如果是这一帧的点,咱们什么都还不知道,所以置信度处于中间值0.5。

2.2.1一阶段的Box预测

图4 一阶段预测的结构图

2.2.2二阶段的Box优化以及形状完善

都是比较细节的点了,损失函数如下

3、实验结果

3、实验结果

这个性能提升挺大的,运算速度也能达到57FPS,内存消耗比BAT小31.1%。但是性能受到刷新率的影响,即在10Hz上的数据集上训练,拿到2Hz的数据集上就不行。

4、总结作者:在这项工作中,我们重新审视了激光雷达点云中的3D SOT,并提出用一种新的以运动为中心的范式来处理它,这被证明是对基于匹配的Siamese范式的极好补充。除了新的范例之外,我们还提出了一种特定的以运动为中心的跟踪算法MM-Track,它在各个方面都显著优于现有技术。大量分析证实,以运动为中心的模型对干扰和外观变化具有鲁棒性,并且可以直接受益于以前基于匹配的跟踪器。我们相信,以运动为中心的范式可以作为指导未来此类算法设计的主要原则。在未来,我们可能会尝试通过考虑更多帧,并在更精细的设计下将其与外观匹配相结合来改进MM算法

笔者:性能提升真的是很大。但是这种所谓的Motion-Centric我感觉并不独特,如SimTrack在思想上就和这篇文章比较类似。但是在3D单目标跟踪领域,直接使用Motion,而不使用appearence的算法,似乎是没有看到过。最近的文章似乎都在阐述一个趋势,即3D领域的点云本身的外观信息不可靠,只能作为Motion的辅助?

备注:作者也是我们「3D视觉从入门到精通」特邀嘉宾:一个超干货的3D视觉学习社区

本文仅做学术分享,如有侵权,请联系删文。

3D视觉工坊精品课程官网:3dcver.com

1.面向自动驾驶领域的多传感器数据融合技术

2.面向自动驾驶领域的3D点云目标检测全栈学习路线!(单模态+多模态/数据+代码) 3.彻底搞透视觉三维重建:原理剖析、代码讲解、及优化改进 4.国内首个面向工业级实战的点云处理课程 5.激光-视觉-IMU-GPS融合SLAM算法梳理和代码讲解 6.彻底搞懂视觉-惯性SLAM:基于VINS-Fusion正式开课啦 7.彻底搞懂基于LOAM框架的3D激光SLAM: 源码剖析到算法优化 8.彻底剖析室内、室外激光SLAM关键算法原理、代码和实战(cartographer+LOAM +LIO-SAM)

9.从零搭建一套结构光3D重建系统[理论+源码+实践]

10.单目深度估计方法:算法梳理与代码实现

11.自动驾驶中的深度学习模型部署实战

12.相机模型与标定(单目+双目+鱼眼)

13.重磅!四旋翼飞行器:算法与实战

14.ROS2从入门到精通:理论与实战

15.国内首个3D缺陷检测教程:理论、源码与实战

重磅!3DCVer-学术论文写作投稿 交流群已成立

扫码添加小助手微信,可申请加入3D视觉工坊-学术论文写作与投稿 微信交流群,旨在交流顶会、顶刊、SCI、EI等写作与投稿事宜。

同时也可申请加入我们的细分方向交流群,目前主要有3D视觉、CV&深度学习、SLAM、三维重建、点云后处理、自动驾驶、多传感器融合、CV入门、三维测量、VR/AR、3D人脸识别、医疗影像、缺陷检测、行人重识别、目标跟踪、视觉产品落地、视觉竞赛、车牌识别、硬件选型、学术交流、求职交流、ORB-SLAM系列源码交流、深度估计等微信群。

一定要备注:研究方向+学校/公司+昵称,例如:”3D视觉 + 上海交大 + 静静“。请按照格式备注,可快速被通过且邀请进群。原创投稿也请联系。

▲长按加微信群或投稿

▲长按关注公众号

3D视觉从入门到精通知识星球:针对3D视觉领域的视频课程(三维重建系列、三维点云系列、结构光系列、手眼标定、相机标定、激光/视觉SLAM、自动驾驶等)、知识点汇总、入门进阶学习路线、最新paper分享、疑问解答五个方面进行深耕,更有各类大厂的算法工程人员进行技术指导。与此同时,星球将联合知名企业发布3D视觉相关算法开发岗位以及项目对接信息,打造成集技术与就业为一体的铁杆粉丝聚集区,近4000星球成员为创造更好的AI世界共同进步,知识星球入口:

学习3D视觉核心技术,扫描查看介绍,3天内无条件退款

圈里有高质量教程资料、答疑解惑、助你高效解决问题

觉得有用,麻烦给个赞和在看~