来源丨机器之心

编辑丨极市平台

引言参考视频目标分割(Referring VOS, RVOS)是一个新兴起的任务,它旨在根据参考文本,从一段视频序列中分割出文本所指述的对象。与半监督视频目标分割相比,RVOS 只依赖抽象的语言描述而不是像素级的参考掩膜,为人机交互提供了一种更方便的选择,因此受到了广泛关注。

论文链接:https://www.aaai.org/AAAI22Papers/AAAI-1100.LiD.pdf

该研究的主要目的是为解决现有 RVOS 任务中所面临的两大挑战:

-

如何将文本信息、图片信息进行跨模态融合,从而既保持两种模态间的尺度一致性,又能充分地将文本所提供的有用特征参考充分融入到图片特征中;

-

如何抛弃现有方法的二阶段策略(即先在图片级别逐帧得到粗略的结果,再利用该结果作为参考,经过增强时序信息的结构细化得到最终预测),将整个 RVOS 任务统一进单阶段的框架中。

对此,该研究提出了一种跨模态元迁移的端到端 RVOS 框架 ——YOFO,其主要的贡献和创新点为:

-

只需单阶段推理,即可实现利用参考文本信息直接得到视频目标的分割结果,在两个主流的数据集 ——Ref-DAVIS2017 和 Ref-Youtube-VOS 上获得的效果超越了目前所有二阶段方法;

-

提出了一个元迁移(Meta-Transfer)模块来增强时序信息,从而实现了更聚焦于目标的特征学习;

-

提出了一个多尺度跨模态特征挖掘(Multi-Scale Cross-Modal Feature Mining)模块,能够充分融合语言、图片中的有用特征。

YOFO 框架主要流程如下:输入图片和文本先分别经过图片编码器和语言编码器提取特征,随后在多尺度跨模态特征挖掘模块进行融合。融合后的双模态特征在包含了记忆库的元迁移模块中进行简化,排除掉语言特征中的冗余信息,同时能保存时序信息来增强时间相关性,最后通过一个解码器得到分割结果。

图 1:YOFO 框架主要流程

图 1:YOFO 框架主要流程

多尺度跨模态特征挖掘模块:该模块通过逐级融合不同尺度的两个模态特征,能够保持图像特征所传达的尺度信息与语言特征间的一致性,更重要的是保证了语言信息不会在融合过程中被多尺度图像信息所淡化淹没。

图 2:多尺度跨模态特征挖掘模块。

图 2:多尺度跨模态特征挖掘模块。

元迁移模块:采用了一种 learning-to-learn 策略,过程可以简单地描述为以下的映射函数。迁移函数 是一个卷积, 则 是它的卷积核参数:

优化的过程可以表达为以下目标函数:

其中,M 代表能够储存历史信息的记忆库,W 代表不同位置的权重,能够对特征中不同的位置赋予不同的关注度,Y 代表储存在记忆库中的每个视频帧的双模态特征。该优化过程尽可能地使元迁移函数具有重构双模态特征的能力,同时也使得整个框架能够进行端到端的训练。

训练和测试:训练时所使用的损失函数是 lovasz loss,训练集为两个视频数据集 Ref-DAVIS2017、Ref-Youtube-VOS,并通过静态数据集 Ref-COCO 进行随机仿射变换模拟视频数据作为辅助训练。元迁移的过程在训练和预测时都要进行,整个网络在 1080ti 上的运行速度达到了 10FPS。

实验结果研究采用的方法在两个主流 RVOS 数据集(Ref-DAVIS2017 和 Ref-Youtube-VOS)上均取得了优异的效果,量化指标及部分可视化效果图如下:

图 3:在两个主流数据集上的量化指标。

图 3:在两个主流数据集上的量化指标。 图 4:在 VOS 数据集上的可视化效果。

图 4:在 VOS 数据集上的可视化效果。 图 5:YOFO 的其他可视化效果展示。

图 5:YOFO 的其他可视化效果展示。

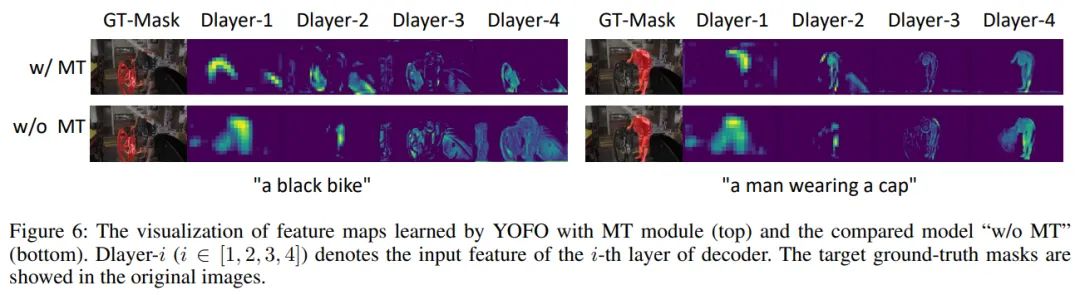

研究还通过一系列的消融实验以说明特征挖掘模块(FM)以及元迁移模块(MT)的有效性。

图 6:特征挖掘模块(FM)以及元迁移模块(MT)的有效性。

图 6:特征挖掘模块(FM)以及元迁移模块(MT)的有效性。

此外,研究分别对使用了 MT 模块和不使用 MT 模块的解码器输出特征进行了可视化,可以明显地看出 MT 模块能够正确地捕捉到语言所描述的内容且对干扰噪声进行过滤。

图 7:使用 MT 模块前后的解码器输出特征对比。

关于研究团队

图 7:使用 MT 模块前后的解码器输出特征对比。

关于研究团队

本论文由美图影像研究院(MT Lab)和大连理工大学卢湖川团队的研究者们共同提出。美图影像研究院(MT Lab)是美图公司致力于计算机视觉、机器学习、增强现实、云计算等领域的算法研究、工程开发和产品化落地的团队,为美图现有和未来的产品提供核心算法支持,并通过前沿技术推动美图产品发展,被称为「美图技术中枢」,曾先后多次参与 CVPR、ICCV、ECCV 等计算机视觉国际顶级会议,并斩获冠亚军十余项。

本文仅做学术分享,如有侵权,请联系删文。

3D视觉工坊精品课程官网:3dcver.com

1.面向自动驾驶领域的多传感器数据融合技术

2.面向自动驾驶领域的3D点云目标检测全栈学习路线!(单模态+多模态/数据+代码) 3.彻底搞透视觉三维重建:原理剖析、代码讲解、及优化改进 4.国内首个面向工业级实战的点云处理课程 5.激光-视觉-IMU-GPS融合SLAM算法梳理和代码讲解 6.彻底搞懂视觉-惯性SLAM:基于VINS-Fusion正式开课啦 7.彻底搞懂基于LOAM框架的3D激光SLAM: 源码剖析到算法优化 8.彻底剖析室内、室外激光SLAM关键算法原理、代码和实战(cartographer+LOAM +LIO-SAM)

9.从零搭建一套结构光3D重建系统[理论+源码+实践]

10.单目深度估计方法:算法梳理与代码实现

11.自动驾驶中的深度学习模型部署实战

12.相机模型与标定(单目+双目+鱼眼)

13.重磅!四旋翼飞行器:算法与实战

14.ROS2从入门到精通:理论与实战

15.国内首个3D缺陷检测教程:理论、源码与实战

重磅!3DCVer-学术论文写作投稿 交流群已成立

扫码添加小助手微信,可申请加入3D视觉工坊-学术论文写作与投稿 微信交流群,旨在交流顶会、顶刊、SCI、EI等写作与投稿事宜。

同时也可申请加入我们的细分方向交流群,目前主要有3D视觉、CV&深度学习、SLAM、三维重建、点云后处理、自动驾驶、多传感器融合、CV入门、三维测量、VR/AR、3D人脸识别、医疗影像、缺陷检测、行人重识别、目标跟踪、视觉产品落地、视觉竞赛、车牌识别、硬件选型、学术交流、求职交流、ORB-SLAM系列源码交流、深度估计等微信群。

一定要备注:研究方向+学校/公司+昵称,例如:”3D视觉 + 上海交大 + 静静“。请按照格式备注,可快速被通过且邀请进群。原创投稿也请联系。

▲长按加微信群或投稿

▲长按关注公众号

3D视觉从入门到精通知识星球:针对3D视觉领域的视频课程(三维重建系列、三维点云系列、结构光系列、手眼标定、相机标定、激光/视觉SLAM、自动驾驶等)、知识点汇总、入门进阶学习路线、最新paper分享、疑问解答五个方面进行深耕,更有各类大厂的算法工程人员进行技术指导。与此同时,星球将联合知名企业发布3D视觉相关算法开发岗位以及项目对接信息,打造成集技术与就业为一体的铁杆粉丝聚集区,近4000星球成员为创造更好的AI世界共同进步,知识星球入口:

学习3D视觉核心技术,扫描查看介绍,3天内无条件退款

圈里有高质量教程资料、答疑解惑、助你高效解决问题

觉得有用,麻烦给个赞和在看~