点击上方“3D视觉工坊”,选择“星标”

干货第一时间送达

作者丨黄浴

来源丨计算机视觉深度学习和自动驾驶

arXiv上传于6月10日论文"R4D: UTILIZING REFERENCE OBJECTS FOR LONGRANGE DISTANCE ESTIMATION",来自谷歌WayMo公司,发表于ICLR‘22。

估计目标的距离是自动驾驶的一项安全关键任务。现有的方法和数据集侧重于短程目标,而忽视同样重要的长程目标。本文介绍远程距离估计的新方法,采用两个数据集验证。然后,提出R4D,通过场景中已知距离的参考目标来准确估计远程目标距离的框架。

R4D从人类感知中汲取灵感,将针对目标连接到所有参考目标来构建图。图中的边对目标-参考目标之间的相对距离信息进行编码。然后注意模块来衡量参考目标的重要性,并将其组合成一个针对目标的距离预测。

在两个提议数据集上的实验表明,与现有基线方法相比,R4D的有效性和鲁棒性得到显著改善。

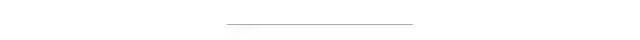

估计目标与车辆的距离对于几个自动驾驶任务至关重要,包括换道、路线规划、速度调整、防撞等。虽然现有的方法和数据集侧重于短距目标,但要知道长距离目标的距离,即超出典型激光雷达范围的目标∼80米(如图所示)-对于高速公路驾驶、重型卡车驾驶和湿路驾驶是必要的。

根据美国交通部的数据,在标准限速为65英里/小时的乡村公路上∼在紧急情况下,乘用车完全停车的距离为145米,大大超过了典型的激光雷达感应范围。重载卡车或雪冰雨等恶劣路况下,所需的停车距离会显著增加。例如,对于卡车运输和湿路驾驶,停车距离分别从145米增加到183米和278米。

此外,考虑到高速公路上突然发生的剧烈刹停是不安全的,超出最小停车距离的目标距离估计仍然至关重要,以便为逐渐减速或换道提供足够的时间。因此,为了有足够的时间做出适当的反应并确保安全,需要自动驾驶系统来估计到远程目标的距离。

这项关键任务称为远程距离估计。具体来说,给定近程激光雷达信号和摄像头图像,此任务的输出是远距离目标的距离(超出激光雷达范围)。按照现有惯例,沿摄像头光轴测量摄像头和目标中心之间的距离。对于这个新任务,引入了两个数据集,伪远程KITTI数据集和Waymo开放数据集-远程标签。

由于KITTI数据集未提供远程目标的真实距离,伪远程KITTI数据集是一个衍生数据集,删除了40米以外的激光雷达点,并将40米以外的所有目标视为远程目标。更重要的是,在Waymo开放数据集的基础上构建了一个新的大规模数据集,包含带标注的真实远程目标(距离从80米到300米)。

总之,虽然这两个数据集在“远距离”(40米或80米以上)的定义上有所不同,但都包括激光雷达点、摄像头图像和远距离目标的距离标签。

无论是激光雷达还是摄像头都无法单独解决这一远程距离估计问题,达到所需的精度。大多数现有的激光雷达技术无法满足远程感知要求。根据Waymo和KITTI自动驾驶汽车数据集,激光雷达的最大射程仅为80米左右,低于上述场景所需的工作距离。

尽管一些先进的激光雷达系统声称可以实现更长的传感范围,例如Waymo的第五代激光雷达系统和Velodyne Alpha PrimeTM,传感范围可达300米,但激光雷达点在远距离很稀疏,因此更容易被遮挡。因此,光靠激光雷达不足以覆盖所有安全-紧要的自动驾驶汽车应用。

另一方面,摄影机可以在更远的范围内感知目标,并捕获丰富的语义信息,如目标外观、几何和上下文提示。然而,其本身并不能提供深度信息。经典的基于几何的算法可以根据摄像头图像中的像素大小来估计标准目标(如轿车、卡车)的距离。然而,由于尺度估计的错误,这些方法在远距离目标上产生了不准确的结果。

基于外观的方法在远距离目标的结果不令人满意。这种方法依赖于单个外观线索来估计场景中的距离,忽视了背景或其他相关信号。从长距来看,目标在视觉上很小,导致外观特征信息较少。虽然激光雷达和摄像头都不能单独解决远程距离估计问题,但这两个信号为这项任务提供了补充线索。

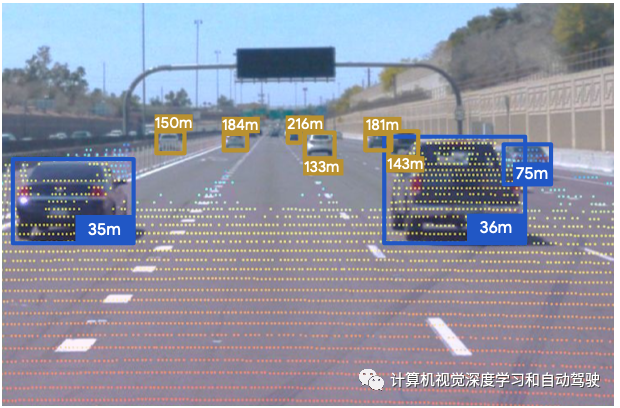

R4D训练一个模型来定位已知距离的远程目标(指定目标),将指定目标和参考表示为图结构。如图所示,将目标定义为节点,这些边将目标连接到参考目标。通过提取目标-参考(Tar-Ref)嵌入,将参考信息传播到远程指定目标。R4D然后将所有目标-参考嵌入信息反馈给注意模块,该模块权衡不同参考信息的相对重要性,并将其组合成一个距离预测来融合来自不同参考的信息。

受人类估计一个目标相对于其他参考的距离这一观察结果的启发,R4D利用参照物进行远程距离估计。参考可以是目标或点的任意组合,这些目标或点与自动驾驶车辆之间的距离已知且精确,例如激光雷达检测、其他传感器检测到的目标和地图特征等。将指定目标和参考表示为上图“Raw Inputs”虚框所示的图。指定目标及其参考是图的节点。边将指定目标连接到其参考目标,对其成对关系进行编码。

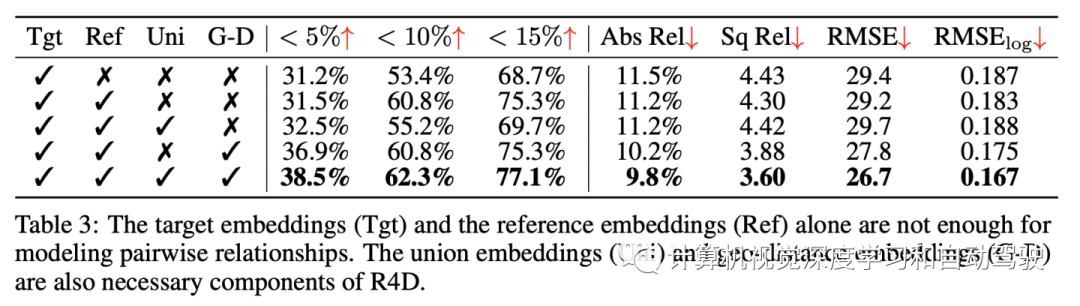

R4D详细的体系结构如图所示:为了建模目标-参考成对关系,建议提取联合嵌入和地理-距离嵌入,分别编码视觉和几何关系;然后,受参考目标不同重要性的直觉启发,引入一个注意模块,选择性地聚合成对关系;最后,R4D通过辅助监督进行训练:目标与其参考之间的相对距离。

用单目相机作为主要传感器来检测远程指定目标,并采用激光雷达检测到的短程目标作为参考。值得注意的是,R4D并不是专门为激光雷达或单目图像设计的,很容易扩展到其他传感器和参考。

用单目相机作为主要传感器来检测远程指定目标,并采用激光雷达检测到的短程目标作为参考。值得注意的是,R4D并不是专门为激光雷达或单目图像设计的,很容易扩展到其他传感器和参考。

1 成对关系建模

-

联合嵌入

成对关系建模的视觉提示应基于指定目标、参考目标以及两个目标之间的场景。因此,提出一种从覆盖两个目标的并集框中提取特征嵌入的简单方法。

-

地理-距离嵌入

为了提供几何提示,用以下内容形成输入:

-

指定目标和参考目标的二维边框中心坐标,以及之间的相对位置偏移。

-

指定目标和参考目标的二维边框大小,以及之间的相对比例。

-

激光雷达3D目标检测器提供的参考物距离。

然后,将该输入送到多层感知器中,生成地理-距离嵌入。

给定指定目标、参考、并集和地理-距离嵌入,将它们连接起来,形成最终的指定目标-参考的嵌入,该嵌入对一对指定目标-参考目标之间的关系进行建模。

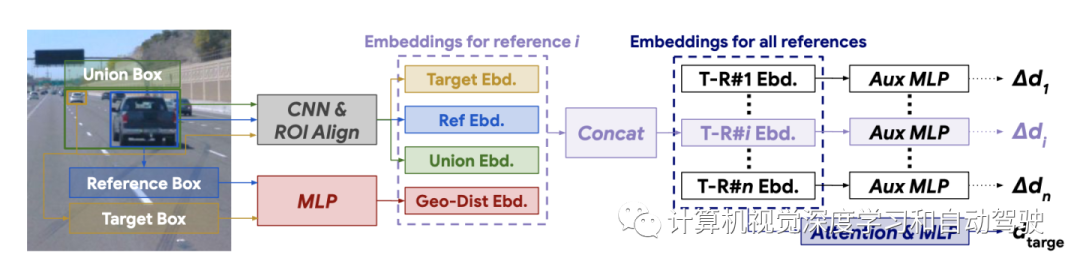

2 基于注意的信息聚合

组合成对的指定目标-参考目标嵌入,估计所指定目标的距离。一种简单的方法是对同一指定目标的所有参考进行平均。然而,从直觉上看,正如实验结果那样,参考目标并不同样重要。例如,当定位位于图像右上角的远处汽车时,图像左下角的汽车可能没有多大帮助。

为了引导模型关注最重要的参考目标,引入一个基于注意的模块。如图所示,遵循VectorNet来构建具有局部和全局信息的嵌入。具体来说,用MLP和平均池化提取全局嵌入(如图黄色)。

然后,全局嵌入与原始指定目标-参考嵌入连接在一起(图中蓝色)。考虑到这些全局-局部嵌入,注意模块用全连接层和softmax层预测并规范化每个参考的重要性权重。最后,用这些权重加权平均融合原始指定目标-参考嵌入,最终得到一个嵌入。

3 相对距离做监督

从指定目标嵌入预测指定目标距离,比从其他间接线索(如参考嵌入)预测指定目标距离更简单。为了鼓励模型学习指定目标和参考目标之间的成对关系,而不是短路线索,作者在这里提供额外的监督。这种附加监督的设计类似于残差表示,残差表示广泛用于计算机视觉,以帮助优化过程。

具体来说,在训练阶段,为每个指定目标-参考目标嵌入添加一个相对(或残余)距离头。指定目标和参考目标之间的相对距离∆d由下式给出 ∆d = dt − dr,其中dt是指定目标的距离。

原始KITTI数据集包含RGB图像、激光雷达点云、二维和三维边框以及其他逐像素注释。有了这些丰富的注释,KITTI数据集上开发了自动驾驶任务的基准,包括场景流估计、深度估计、检测和分割。

尽管KITTI数据集提供了激光雷达点云,但没有提供超出激光雷达感知范围的距离标注。伪远程KITTI数据集,是从原始KITTI数据集派生出来的。通过假设激光雷达的有效探测范围仅为40米,移除更远的激光雷达点。超出该有效传感范围的目标被视为远程指定目标,而其他目标的距离已知并作为输入提供。

值得注意的是,上述指定目标与已知距离的目标之间没有重叠。按照约定,原始训练数据分为两个子集,分别用于训练和验证。不包含任何远程目标的图像将从数据集中删除。因此,伪远程KITTI数据集在训练集和验证集中分别包含2181幅图像4233辆车,以及2340幅图像4033辆车。这个派生数据集的规模相对较小,更重要的是,它不包含真正的远程目标。

鉴于上述伪远程KITTI数据集的局限性,这里构建了一个新的远程数据集,该数据集构建在Waymo开放数据集的基础上,包括距自动驾驶车辆300米的车辆。其标注如下方式生成。

首先,为激光雷达范围内的目标创建3D框。然后,用雷达衍生信号进行粗定位,将激光雷达框扩展到远程。由于雷达分辨率较低,打标注采用平滑的目标轨迹约束,以确保3D框在时间和空间上保持一致。最后,给定长距离目标的3D框,计算到自动驾驶车辆的距离。

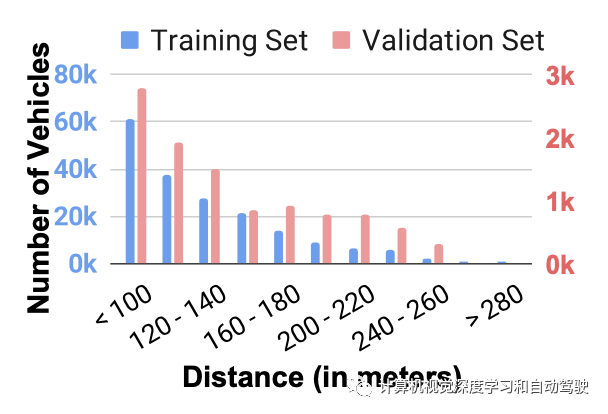

总的来说,如图所示,获得49,056张包含187,938辆远程车辆的训练图像,以及3,578张包含10,483辆远程车辆的验证图像。这些图像跨越一天的不同时间,包括黎明、白天、黄昏和夜间。

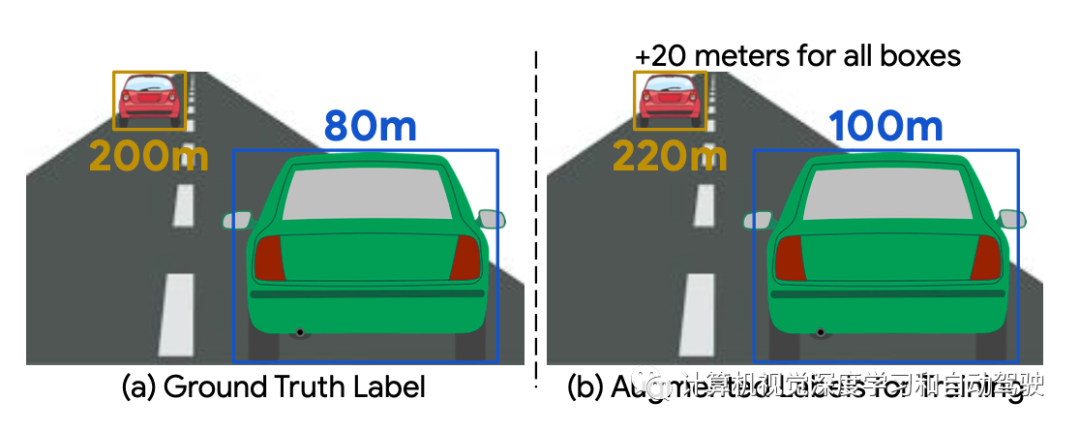

距离增强旨在鼓励R4D从成对关系中学习,并防止只用单一的短路提示(即目标嵌入)。通过强调两两嵌入和距离预测之间的相关性,引导模型关注参考目标和指定目标之间的相对距离。具体来说,保持相对距离固定,扰动参考距离,并期望模型在相同扰动下预测目标距离。

例如,如图(a)所示,指定目标和参考目标之间的相对距离为120米,如果参考目标距离为80米,则模型应预测200米的目标距离(= 80米+120米)。如图(b)所示,当所提供的参考距离受到干扰(例如加20米)时,模型应预测220米(= 100米+120米)作为目标距离,以保持120米的正确相对距离。这有助于模型不过度适应指定目标提供的外观线索,对摄像头参数或视野的细微变化更稳健。

类似的增强技术已成功用于阻止其他深度学习任务中的短路学习。在训练期间,从高斯分布X中采样距离标签扰动∼ N(μ,σ2),μ=0,σ=200。对于伪远程KITTI数据集,用σ=50。

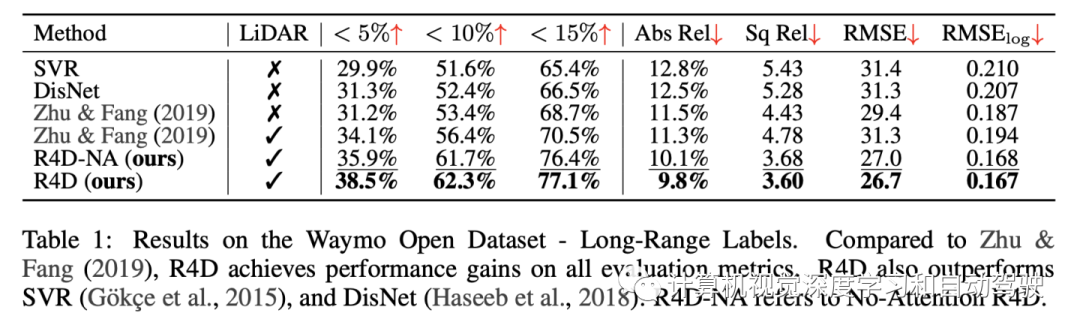

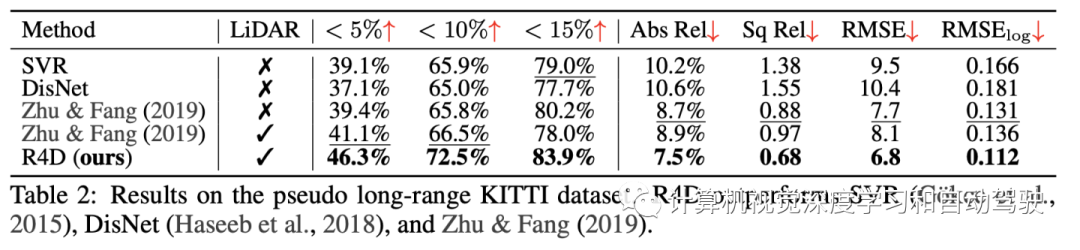

实验结果如下:

本文仅做学术分享,如有侵权,请联系删文。

3D视觉工坊精品课程官网:3dcver.com

1.面向自动驾驶领域的多传感器数据融合技术

2.面向自动驾驶领域的3D点云目标检测全栈学习路线!(单模态+多模态/数据+代码) 3.彻底搞透视觉三维重建:原理剖析、代码讲解、及优化改进 4.国内首个面向工业级实战的点云处理课程 5.激光-视觉-IMU-GPS融合SLAM算法梳理和代码讲解 6.彻底搞懂视觉-惯性SLAM:基于VINS-Fusion正式开课啦 7.彻底搞懂基于LOAM框架的3D激光SLAM: 源码剖析到算法优化 8.彻底剖析室内、室外激光SLAM关键算法原理、代码和实战(cartographer+LOAM +LIO-SAM)

9.从零搭建一套结构光3D重建系统[理论+源码+实践]

10.单目深度估计方法:算法梳理与代码实现

11.自动驾驶中的深度学习模型部署实战

12.相机模型与标定(单目+双目+鱼眼)

13.重磅!四旋翼飞行器:算法与实战

14.ROS2从入门到精通:理论与实战

15.国内首个3D缺陷检测教程:理论、源码与实战

重磅!3DCVer-学术论文写作投稿 交流群已成立

扫码添加小助手微信,可申请加入3D视觉工坊-学术论文写作与投稿 微信交流群,旨在交流顶会、顶刊、SCI、EI等写作与投稿事宜。

同时也可申请加入我们的细分方向交流群,目前主要有3D视觉、CV&深度学习、SLAM、三维重建、点云后处理、自动驾驶、多传感器融合、CV入门、三维测量、VR/AR、3D人脸识别、医疗影像、缺陷检测、行人重识别、目标跟踪、视觉产品落地、视觉竞赛、车牌识别、硬件选型、学术交流、求职交流、ORB-SLAM系列源码交流、深度估计等微信群。

一定要备注:研究方向+学校/公司+昵称,例如:”3D视觉 + 上海交大 + 静静“。请按照格式备注,可快速被通过且邀请进群。原创投稿也请联系。

▲长按加微信群或投稿

▲长按关注公众号

3D视觉从入门到精通知识星球:针对3D视觉领域的视频课程(三维重建系列、三维点云系列、结构光系列、手眼标定、相机标定、激光/视觉SLAM、自动驾驶等)、知识点汇总、入门进阶学习路线、最新paper分享、疑问解答五个方面进行深耕,更有各类大厂的算法工程人员进行技术指导。与此同时,星球将联合知名企业发布3D视觉相关算法开发岗位以及项目对接信息,打造成集技术与就业为一体的铁杆粉丝聚集区,近4000星球成员为创造更好的AI世界共同进步,知识星球入口:

学习3D视觉核心技术,扫描查看介绍,3天内无条件退款

圈里有高质量教程资料、答疑解惑、助你高效解决问题

觉得有用,麻烦给个赞和在看~