点击上方“3D视觉工坊”,选择“星标”

干货第一时间送达

作者丨孟浩、金晟

来源丨商汤学术

导读

本文主要介绍商汤智能感知终端团队,发表在 ECCV 2022 上的工作。针对3D交互双手姿态估计问题,作者采用分而治之的策略,把交互的双手姿态估计问题,解耦成两个单手姿态估计问题。

作者提出了一种基于去遮挡和移除的3D交互手姿态估计框架,补全目标手被遮挡的部分,并移除另一只有干扰的手。此外,作者还构建了一个大规模数据集Amodal InterHand Dataset (AIH),用以训练手势去遮挡和移除网络。实验结果表明,论文提出的框架在InterHand2.6M 和 Tzionas 两个主流的公开数据集上,都获得了显著的性能提升。

论文名称:3D Interacting Hand Pose Estimation by Hand De-occlusion and Removal

Part 1 动机和背景

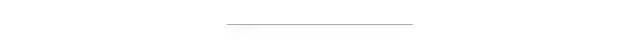

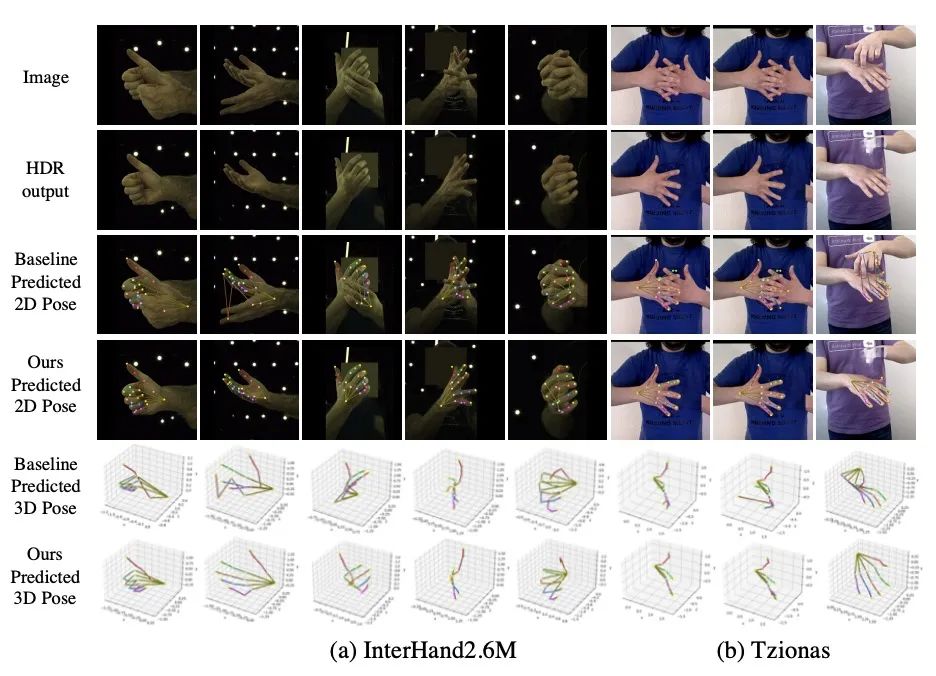

图1 本文算法(右)与baseline(左)的对比

手,是人和世界交互的主要工具。3D交互手姿态估计,指从单目彩色图中,恢复出一个人两只互相交互的手的骨架。它是人机交互、AR/VR、手语理解等诸多现实应用的基础。

与被充分研究的单手姿态估计任务不同,交互手3D姿态估计是近两年来刚兴起的学术方向。现存的工作会直接同时预测交互手的左右两手的姿态,而我们则另辟蹊径,将交互手姿态估计任务,解耦成左右两手分别的单手姿态估计任务。这样,我们就可以充分利用当下单手姿态估计技术的最新进展。

然而相比通常的单手姿态估计任务来说,交互手姿态估计有以下两个难点:一是左右手间可能存在的严重的遮挡,难以估计被遮挡的手的姿态;二是左右手颜色纹理相近有歧义性,预测一只手的姿态可能会因另一只手的存在而被干扰。为了解决这两个困难,我们提出了去遮挡和移除框架,旨在预测一只手的姿态时,补全它被遮挡的部分,并移除有干扰的另一只手的部分。由图1的示例可见,在用去遮挡和移除框架后,交互手的图片会恢复右手被遮挡的部分,也会移除有干扰的左手的部分,进而转换成右手的单手姿态估计任务。

此外,我们还构建了第一个大规模的合成交互手数据集(Amodal InterHand Dataset)。该数据集具有很多应用前景,如交互式双手姿态估计、Amodal & modal的实例分割、以及手部去遮挡。

Part 2 方法

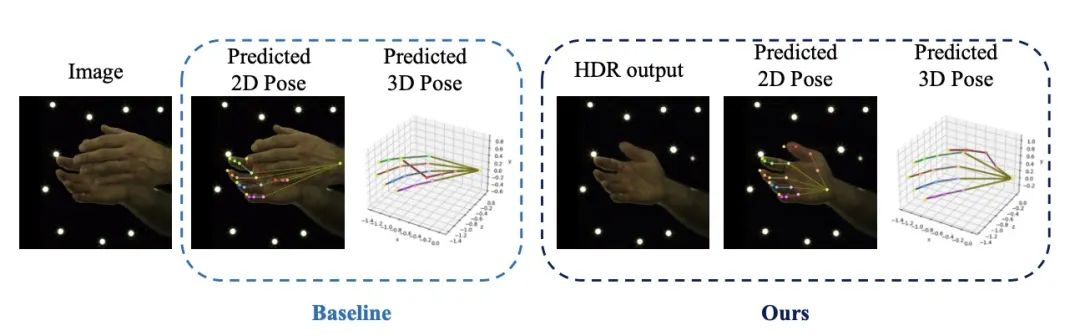

图2 本文提出的框架示意图

本文的框架包括三个部分:手部非模态分割模块(HASM)、手部去遮挡和移除模块(HDRM)、单手姿态估计模块(SHPE)。我们首先用HASM去分割图像中左右手的模态和非模态掩码,在得到掩码后,我们可以分别定位左右两手的位置并对图片进行裁剪。之后,我们利用HDRM恢复手被遮挡的部分并移除另一只有干扰的手。这样,一个交互手的图片会被转换成左右两手的单个手的图片,通过SHPE后可以得到左右手分别的姿态。

2.1 手部非模态分割模块(HASM)

我们基于mmsegmentation框架,从交互手的图片中分割出四种掩码:左手可见区域、左手完整区域、右手可见区域和右手完整区域。

2.2 手部去遮挡和移除模块(HDRM)

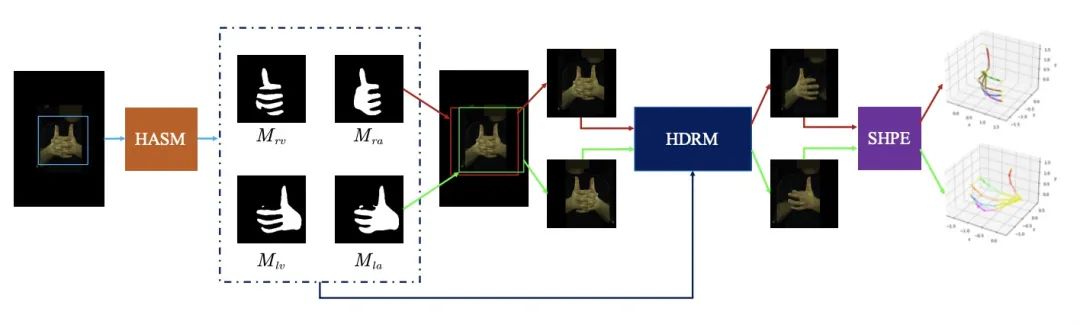

图3 HDRNet示意图

以右手为例,首先根据2.1预测的掩码,以右手完整部分掩码为中心,裁剪得到图片 。而HDRNet的输入则有以下四部分拼接而成:(1) 图片右手被遮挡区域被涂黑 ;(2)右手可见部分掩码 ;(3)I图片左手多余区域被涂黑 ;(4)除左右两手外的背景区域的掩码 。我们借鉴经典的inpainting方法中的网络结构(UNet + Partial Convolutions),并在其中加入了一些Transformer结构,来增强图像特征、扩大感受野,以及让网络关注更重要的图像区域。网络HDRNet最终预测出右手被遮挡区域的像素,以及左手多余区域背后背景的像素,这样最终预测结果即为单个右手的图片。

2.3 单手姿态估计模块(SHPE)

由于SHPE不是本文的重点,因此我们使用了一个简单有效的开源方法MinimalHand作为我们的baseline。

Part 3 AIH虚拟交互手数据集

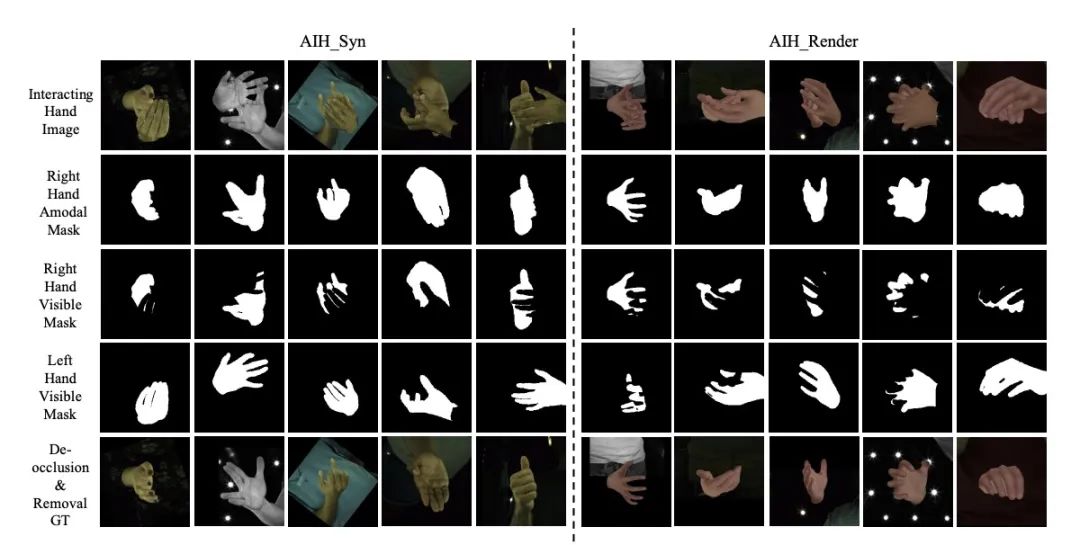

图4 AIH数据集中的样例

为了充分训练我们提出的HDRM网络,我们基于InterHand2.6M V1.0数据集,构建了第一个大规模的虚拟合成的Amodal交互手数据集(AIH)。AIH有大约300万样本组成,其中AIH_Syn 有220万样本,AIH_Render有70万样本。前者是将InterHand2.6M V1.0数据集的单个右手或单个左手的图片,进行复制粘贴,合成的交互手图片。后者是将InterHand2.6M V1.0数据集的双手mesh装饰上纹理,经过随机的旋转和平移,最终渲染到随机的数据集背景上得到的图片。图4展示了AIH数据集的可视化效果。

Part 4 实验结果

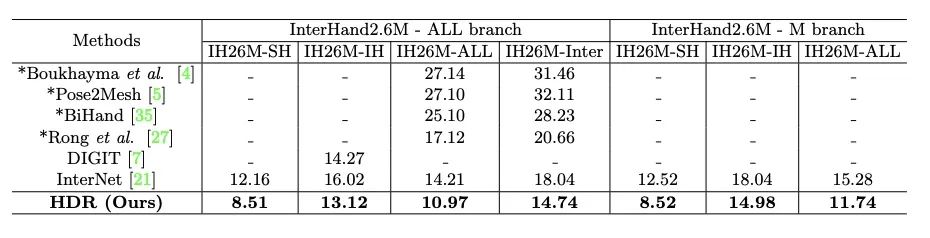

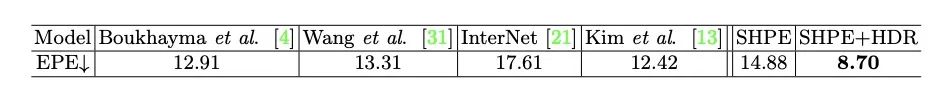

我们在 InterHand2.6M V1.0 和 Tzionas 两个主流的数据集上做了实验。如表1和表2所示,定量实验表明,我们提出的算法,取得了最优的精度。而且在耗时方面,在Tesla P40机器上单个样本预测,HDRM(我们的主要贡献点)只需要0.6ms,占整个框架预测时间47.2ms中很小一部分。更多可视化效果见图5。

表1 InterHand2.6M V1.0 数据集的定量结果对比

表2 Tzionas 数据集的定量结果对比

图5 更多可视化结果

本文仅做学术分享,如有侵权,请联系删文。

干货下载与学习

后台回复:巴塞罗那自治大学课件,即可下载国外大学沉淀数年3D Vison精品课件

后台回复:计算机视觉书籍,即可下载3D视觉领域经典书籍pdf

后台回复:3D视觉课程,即可学习3D视觉领域精品课程

3D视觉工坊精品课程官网:3dcver.com

1.面向自动驾驶领域的多传感器数据融合技术

2.面向自动驾驶领域的3D点云目标检测全栈学习路线!(单模态+多模态/数据+代码) 3.彻底搞透视觉三维重建:原理剖析、代码讲解、及优化改进 4.国内首个面向工业级实战的点云处理课程 5.激光-视觉-IMU-GPS融合SLAM算法梳理和代码讲解 6.彻底搞懂视觉-惯性SLAM:基于VINS-Fusion正式开课啦 7.彻底搞懂基于LOAM框架的3D激光SLAM: 源码剖析到算法优化 8.彻底剖析室内、室外激光SLAM关键算法原理、代码和实战(cartographer+LOAM +LIO-SAM)

9.从零搭建一套结构光3D重建系统[理论+源码+实践]

10.单目深度估计方法:算法梳理与代码实现

11.自动驾驶中的深度学习模型部署实战

12.相机模型与标定(单目+双目+鱼眼)

13.重磅!四旋翼飞行器:算法与实战

14.ROS2从入门到精通:理论与实战

15.国内首个3D缺陷检测教程:理论、源码与实战

16.基于Open3D的点云处理入门与实战教程

重磅!3DCVer-学术论文写作投稿 交流群已成立

扫码添加小助手微信,可申请加入3D视觉工坊-学术论文写作与投稿 微信交流群,旨在交流顶会、顶刊、SCI、EI等写作与投稿事宜。

同时也可申请加入我们的细分方向交流群,目前主要有3D视觉、CV&深度学习、SLAM、三维重建、点云后处理、自动驾驶、多传感器融合、CV入门、三维测量、VR/AR、3D人脸识别、医疗影像、缺陷检测、行人重识别、目标跟踪、视觉产品落地、视觉竞赛、车牌识别、硬件选型、学术交流、求职交流、ORB-SLAM系列源码交流、深度估计等微信群。

一定要备注:研究方向+学校/公司+昵称,例如:”3D视觉 + 上海交大 + 静静“。请按照格式备注,可快速被通过且邀请进群。原创投稿也请联系。

▲长按加微信群或投稿,加微信:dddvision

▲长按关注公众号

3D视觉从入门到精通知识星球:针对3D视觉领域的视频课程(三维重建系列、三维点云系列、结构光系列、手眼标定、相机标定、激光/视觉SLAM、自动驾驶等)、知识点汇总、入门进阶学习路线、最新paper分享、疑问解答五个方面进行深耕,更有各类大厂的算法工程人员进行技术指导。与此同时,星球将联合知名企业发布3D视觉相关算法开发岗位以及项目对接信息,打造成集技术与就业为一体的铁杆粉丝聚集区,近4000星球成员为创造更好的AI世界共同进步,知识星球入口:

学习3D视觉核心技术,扫描查看介绍,3天内无条件退款

圈里有高质量教程资料、答疑解惑、助你高效解决问题

觉得有用,麻烦给个赞和在看~