作者丨ncepu_Chen@CSDN

来源丨https://blog.csdn.net/ncepu_Chen/article/details/116784462?spm=1001.2014.3001.5502

编辑丨3D视觉工坊

运行官方Demo

以TUM数据集为例,运行Demo的命令:

./Examples/RGB-D/rgbd_tum Vocabulary/ORBvoc.txt Examples/RGB-D/TUM1.yaml PATH_TO_SEQUENCE_FOLDER ASSOCIATIONS_FILE

rgbd_tum.cc的源码:

int main(int argc, char **argv) {

// 判断输入参数个数

if (argc != 5) {

cerr << endl << "Usage: ./rgbd_tum path_to_vocabulary path_to_settings path_to_sequence path_to_association" << endl;

return 1;

}

// step1. 读取图片及左右目关联信息

vectorvstrImageFilenamesRGB;

vectorvstrImageFilenamesD;

vectorvTimestamps;

string strAssociationFilename = string(argv[4]);

LoadImages(strAssociationFilename, vstrImageFilenamesRGB, vstrImageFilenamesD, vTimestamps);

// step2. 检查图片文件及输入文件的一致性

int nImages = vstrImageFilenamesRGB.size();

if (vstrImageFilenamesRGB.empty()) {

cerr << endl << "No images found in provided path." << endl;

return 1;

} else if (vstrImageFilenamesD.size() != vstrImageFilenamesRGB.size()) {

cerr << endl << "Different number of images for rgb and depth." << endl;

return 1;

}

// step3. 创建SLAM对象,它是一个 ORB_SLAM2::System 类型变量

ORB_SLAM2::System SLAM(argv[1], argv[2], ORB_SLAM2::System::RGBD, true);

vectorvTimesTrack;

vTimesTrack.resize(nImages);

cv::Mat imRGB, imD;

// step4. 遍历图片,进行SLAM

for (int ni = 0; ni < nImages; ni++) {

// step4.1. 读取图片

imRGB = cv::imread(string(argv[3]) + "/" + vstrImageFilenamesRGB[ni], CV_LOAD_IMAGE_UNCHANGED);

imD = cv::imread(string(argv[3]) + "/" + vstrImageFilenamesD[ni], CV_LOAD_IMAGE_UNCHANGED);

double tframe = vTimestamps[ni];

// step4.2. 进行SLAM

SLAM.TrackRGBD(imRGB, imD, tframe);

// step4.3. 加载下一张图片

double T = 0;

if (ni < nImages - 1)

T = vTimestamps[ni + 1] - tframe;

else if (ni > 0)

T = tframe - vTimestamps[ni - 1];

if (ttrack < T)

usleep((T - ttrack) * 1e6);

}

// step5. 停止SLAM

SLAM.Shutdown();

}

运行程序rgbd_tum时传入了一个重要的配置文件TUM1.yaml,其中保存了相机参数和ORB特征提取参数:

%YAML:1.0 ## 相机参数 Camera.fx: 517.306408 Camera.fy: 516.469215 Camera.cx: 318.643040 Camera.cy: 255.313989 Camera.k1: 0.262383 Camera.k2: -0.953104 Camera.p1: -0.005358 Camera.p2: 0.002628 Camera.k3: 1.163314 Camera.width: 640 Camera.height: 480 Camera.fps: 30.0 # Camera frames per second Camera.bf: 40.0# IR projector baseline times fx (aprox.) Camera.RGB: 1# Color order of the images (0: BGR, 1: RGB. It is ignored if images are grayscale) ThDepth: 40.0# Close/Far threshold. Baseline times. DepthMapFactor: 5000.0# Deptmap values factor ## ORB特征提取参数 ORBextractor.nFeatures: 1000# ORB Extractor: Number of features per image ORBextractor.scaleFactor: 1.2# ORB Extractor: Scale factor between levels in the scale pyramid ORBextractor.nLevels: 8# ORB Extractor: Number of levels in the scale pyramid ORBextractor.iniThFAST: 20 ORBextractor.minThFAST: 7

阅读代码之前你应该知道的事情

变量命名规则

ORB-SLAM2中的变量遵循一套命名规则:

1、变量名的第一个字母为m表示该变量为某类的成员变量.

2、变量名的第一、二个字母表示数据类型:

·p表示指针类型

·n表示int类型

·b表示bool类型

·s表示std::set类型

·v表示std::vector类型

·l表示std::list类型

·KF表示KeyFrame类型

这种将变量类型写进变量名的命名方法叫做匈牙利命名法.

理解多线程

为什么要使用多线程?

1、加快运算速度:

bool Initializer::Initialize(const Frame &CurrentFrame) {

// ...

thread threadH(&Initializer::FindHomography, this, ref(vbMatchesInliersH), ref(SH), ref(H));

thread threadF(&Initializer::FindFundamental, this, ref(vbMatchesInliersF), ref(SF), ref(F));

// ...

}

2、开两个线程同时计算两个矩阵,在多核处理器上会加快运算速度.

因为系统的随机性,各步骤的运行顺序是不确定的.

Tracking线程不产生关键帧时,LocalMapping和LoopClosing线程基本上处于空转的状态.

而Tracking线程产生关键帧的频率和时机不是固定的,因此需要3个线程同时运行,LocalMapping和LoopClosing线程不断循环查询Tracking线程是否产生关键帧,产生了的话就处理.

// Tracking线程主函数

void Tracking::Track() {

// 进行跟踪

// ...

// 若跟踪成功,根据条件判定是否产生关键帧

if (NeedNewKeyFrame())

// 产生关键帧并将关键帧传给LocalMapping线程

KeyFrame *pKF = new KeyFrame(mCurrentFrame, mpMap, mpKeyFrameDB);

mpLocalMapper->InsertKeyFrame(pKF);

}

// LocalMapping线程主函数

void LocalMapping::Run() {

// 死循环

while (1) {

// 判断是否接收到关键帧

if (CheckNewKeyFrames()) {

// 处理关键帧

// ...

// 将关键帧传给LoopClosing线程

mpLoopCloser->InsertKeyFrame(mpCurrentKeyFrame);

}

// 线程暂停3毫秒,3毫秒结束后再从while(1)循环首部运行

std::this_thread::sleep_for(std::chrono::milliseconds(3));

}

}

// LoopClosing线程主函数

void LoopClosing::Run() {

// 死循环

while (1) {

// 判断是否接收到关键帧

if (CheckNewKeyFrames()) {

// 处理关键帧

// ...

}

// 查看是否有外部线程请求复位当前线程

ResetIfRequested();

// 线程暂停5毫秒,5毫秒结束后再从while(1)循环首部运行

std::this_thread::sleep_for(std::chrono::milliseconds(5));

}

}

多线程中的锁

为防止多个线程同时操作同一变量造成混乱,引入锁机制:

将成员函数本身设为私有变量(private或protected),并在操作它们的公有函数内加锁.

class KeyFrame {

protected:

KeyFrame* mpParent;

public:

void KeyFrame::ChangeParent(KeyFrame *pKF) {

unique_locklockCon(mMutexConnections);// 加锁

mpParent = pKF;

pKF->AddChild(this);

}

KeyFrame *KeyFrame::GetParent() {

unique_locklockCon(mMutexConnections);// 加锁

return mpParent;

}

}

一把锁在某个时刻只有一个线程能够拿到,如果程序执行到某个需要锁的位置,但是锁被别的线程拿着不释放的话,当前线程就会暂停下来;直到其它线程释放了这个锁,当前线程才能拿走锁并继续向下执行.

备注:感谢微信公众号「3D视觉工坊」整理。

什么时候加锁和释放锁?

unique_locklockCon(mMutexConnections);这句话就是加锁,锁的有效性仅限于大括号{}之内,也就是说,程序运行出大括号之后就释放锁了.因此可以看到有一些代码中加上了看似莫名其妙的大括号.

void KeyFrame::EraseConnection(KeyFrame *pKF) {

// 第一部分加锁

{

unique_locklock(mMutexConnections);

if (mConnectedKeyFrameWeights.count(pKF)) {

mConnectedKeyFrameWeights.erase(pKF);

bUpdate = true;

}

}// 程序运行到这里就释放锁,后面的操作不需要抢到锁就能执行

UpdateBestCovisibles();

}

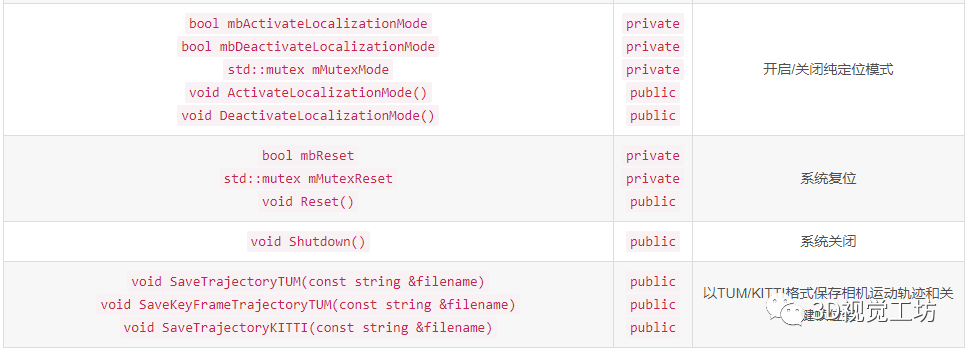

SLAM主类System

System类是ORB-SLAM2系统的主类,先分析其主要的成员函数和成员变量:

构造函数

System(const string &strVocFile, string &strSettingsFile, const eSensor sensor, const bool bUseViewer=true): 构造函数

System::System(const string &strVocFile, const string &strSettingsFile, const eSensor sensor, const bool bUseViewer) :

mSensor(sensor), mpViewer(static_cast(NULL)), mbReset(false), mbActivateLocalizationMode(false), mbDeactivateLocalizationMode(false) {

// step1. 初始化各成员变量

// step1.1. 读取配置文件信息

cv::FileStorage fsSettings(strSettingsFile.c_str(), cv::FileStorage::READ);

// step1.2. 创建ORB词袋

mpVocabulary = new ORBVocabulary();

// step1.3. 创建关键帧数据库,主要保存ORB描述子倒排索引(即根据描述子查找拥有该描述子的关键帧)

mpKeyFrameDatabase = new KeyFrameDatabase(*mpVocabulary);

// step1.4. 创建地图

mpMap = new Map();

// step2. 创建3大线程: Tracking、LocalMapping和LoopClosing

// step2.1. 主线程就是Tracking线程,只需创建Tracking对象即可

mpTracker = new Tracking(this, mpVocabulary, mpFrameDrawer, mpMapDrawer, mpMap, mpKeyFrameDatabase, strSettingsFile, mSensor);

// step2.2. 创建LocalMapping线程及mpLocalMapper

mpLocalMapper = new LocalMapping(mpMap, mSensor==MONOCULAR);

mptLocalMapping = new thread(&ORB_SLAM2::LocalMapping::Run, mpLocalMapper);

// step2.3. 创建LoopClosing线程及mpLoopCloser

mpLoopCloser = new LoopClosing(mpMap, mpKeyFrameDatabase, mpVocabulary, mSensor!=MONOCULAR);

mptLoopClosing = new thread(&ORB_SLAM2::LoopClosing::Run, mpLoopCloser);

// step3. 设置线程间通信

mpTracker->SetLocalMapper(mpLocalMapper);

mpTracker->SetLoopClosing(mpLoopCloser);

mpLocalMapper->SetTracker(mpTracker);

mpLocalMapper->SetLoopCloser(mpLoopCloser);

mpLoopCloser->SetTracker(mpTracker);

mpLoopCloser->SetLocalMapper(mpLocalMapper);

}

LocalMapping和LoopClosing线程在System类中有对应的std::thread线程成员变量,为什么Tracking线程没有对应的std::thread成员变量?

因为Tracking线程就是主线程,而LocalMapping和LoopClosing线程是其子线程,主线程通过持有两个子线程的指针(mptLocalMapping和mptLoopClosing)控制子线程.

(ps: 虽然在编程实现上三大主要线程构成父子关系,但逻辑上我们认为这三者是并发的,不存在谁控制谁的问题).

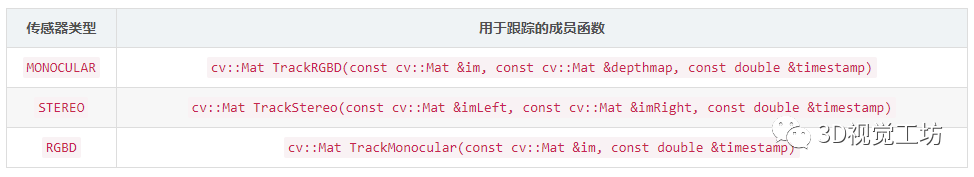

跟踪函数System对象所在的主线程就是跟踪线程,针对不同的传感器类型有3个用于跟踪的函数,其内部实现就是调用成员变量mpTracker的GrabImageMonocular(GrabImageStereo或GrabImageRGBD)方法.

传感器类型用于跟踪的成员函数

cv::Mat System::TrackMonocular(const cv::Mat &im, const double ×tamp) {

cv::Mat Tcw = mpTracker->GrabImageMonocular(im, timestamp);

unique_locklock(mMutexState);

mTrackingState = mpTracker->mState;

mTrackedMapPoints = mpTracker->mCurrentFrame.mvpMapPoints;

mTrackedKeyPointsUn = mpTracker->mCurrentFrame.mvKeysUn;

return Tcw;

}

本文仅做学术分享,如有侵权,请联系删文。

干货下载与学习

后台回复:巴塞罗那自治大学课件,即可下载国外大学沉淀数年3D Vison精品课件

后台回复:计算机视觉书籍,即可下载3D视觉领域经典书籍pdf

后台回复:3D视觉课程,即可学习3D视觉领域精品课程

3D视觉工坊精品课程官网:3dcver.com

1.面向自动驾驶领域的多传感器数据融合技术

2.面向自动驾驶领域的3D点云目标检测全栈学习路线!(单模态+多模态/数据+代码) 3.彻底搞透视觉三维重建:原理剖析、代码讲解、及优化改进 4.国内首个面向工业级实战的点云处理课程 5.激光-视觉-IMU-GPS融合SLAM算法梳理和代码讲解 6.彻底搞懂视觉-惯性SLAM:基于VINS-Fusion正式开课啦 7.彻底搞懂基于LOAM框架的3D激光SLAM: 源码剖析到算法优化 8.彻底剖析室内、室外激光SLAM关键算法原理、代码和实战(cartographer+LOAM +LIO-SAM)

9.从零搭建一套结构光3D重建系统[理论+源码+实践]

10.单目深度估计方法:算法梳理与代码实现

11.自动驾驶中的深度学习模型部署实战

12.相机模型与标定(单目+双目+鱼眼)

13.重磅!四旋翼飞行器:算法与实战

14.ROS2从入门到精通:理论与实战

15.国内首个3D缺陷检测教程:理论、源码与实战

16.基于Open3D的点云处理入门与实战教程

重磅!3DCVer-学术论文写作投稿 交流群已成立

扫码添加小助手微信,可申请加入3D视觉工坊-学术论文写作与投稿 微信交流群,旨在交流顶会、顶刊、SCI、EI等写作与投稿事宜。

同时也可申请加入我们的细分方向交流群,目前主要有3D视觉、CV&深度学习、SLAM、三维重建、点云后处理、自动驾驶、多传感器融合、CV入门、三维测量、VR/AR、3D人脸识别、医疗影像、缺陷检测、行人重识别、目标跟踪、视觉产品落地、视觉竞赛、车牌识别、硬件选型、学术交流、求职交流、ORB-SLAM系列源码交流、深度估计等微信群。

一定要备注:研究方向+学校/公司+昵称,例如:”3D视觉 + 上海交大 + 静静“。请按照格式备注,可快速被通过且邀请进群。原创投稿也请联系。

▲长按加微信群或投稿,加微信:dddvision

▲长按关注公众号

3D视觉从入门到精通知识星球:针对3D视觉领域的视频课程(三维重建系列、三维点云系列、结构光系列、手眼标定、相机标定、激光/视觉SLAM、自动驾驶等)、知识点汇总、入门进阶学习路线、最新paper分享、疑问解答五个方面进行深耕,更有各类大厂的算法工程人员进行技术指导。与此同时,星球将联合知名企业发布3D视觉相关算法开发岗位以及项目对接信息,打造成集技术与就业为一体的铁杆粉丝聚集区,近6000星球成员为创造更好的AI世界共同进步,知识星球入口:

学习3D视觉核心技术,扫描查看介绍,3天内无条件退款

圈里有高质量教程资料、答疑解惑、助你高效解决问题

觉得有用,麻烦给个赞和在看~